Serwer Wikidata MCP

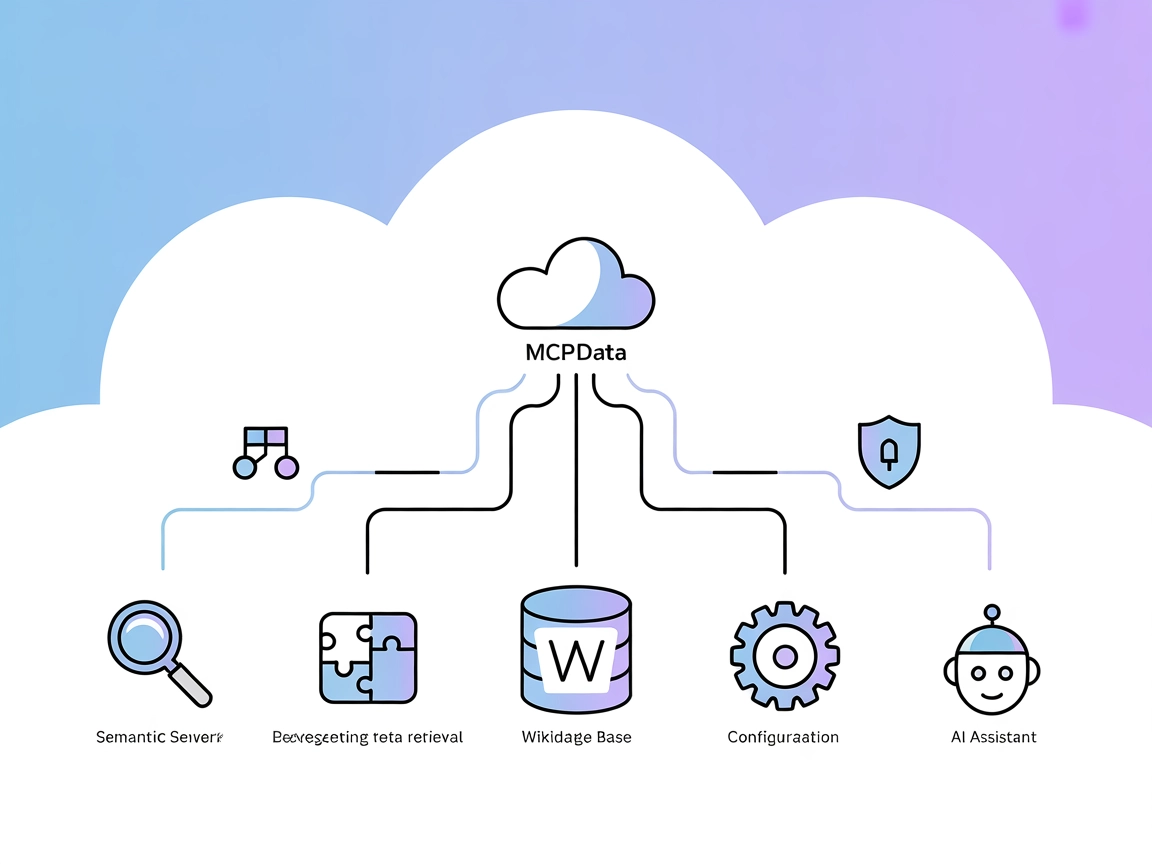

Połącz swojego asystenta AI ze strukturalną wiedzą Wikidata dzięki integracji FlowHunt z serwerem Wikidata MCP—umożliwiając płynne wyszukiwanie semantyczne, ekstrakcję metadanych i zapytania SPARQL.

Do czego służy serwer “Wikidata” MCP?

Serwer Wikidata MCP to implementacja Model Context Protocol (MCP), zaprojektowana do bezpośredniej komunikacji z API Wikidata. Stanowi pomost między asystentami AI a ogromem uporządkowanej wiedzy dostępnej w Wikidata, umożliwiając deweloperom i agentom AI płynne wyszukiwanie identyfikatorów encji i właściwości, ekstrakcję metadanych (takich jak etykiety i opisy) oraz wykonywanie zapytań SPARQL. Udostępniając te możliwości jako narzędzia MCP, serwer pozwala na realizację takich zadań, jak wyszukiwanie semantyczne, pozyskiwanie wiedzy i kontekstowe wzbogacanie w przepływach pracy wymagających zewnętrznych, uporządkowanych danych. Umożliwia to aplikacjom AI pobieranie, zapytania i rozumowanie na podstawie aktualnych informacji z Wikidata.

Lista promptów

W repozytorium ani dokumentacji nie wspomniano o szablonach promptów.

Lista zasobów

W repozytorium ani dokumentacji nie opisano jawnych zasobów MCP.

Lista narzędzi

- search_entity(query: str)

Wyszukaj identyfikator encji Wikidata na podstawie zapytania. - search_property(query: str)

Wyszukaj identyfikator właściwości Wikidata na podstawie zapytania. - get_properties(entity_id: str)

Pobierz właściwości powiązane z podanym identyfikatorem encji Wikidata. - execute_sparql(sparql_query: str)

Wykonaj zapytanie SPARQL na Wikidata. - get_metadata(entity_id: str, language: str = “en”)

Pobierz angielską etykietę i opis dla podanego identyfikatora encji Wikidata.

Przykłady zastosowań tego serwera MCP

- Pobieranie danych semantycznych

Wykorzystaj asystentów AI do wyszukiwania encji lub właściwości w Wikidata, dostarczając użytkownikom dokładnych identyfikatorów do dalszej analizy lub eksploracji. - Automatyczna ekstrakcja metadanych

Automatycznie pobieraj etykiety i opisy encji Wikidata, wzbogacając aplikacje lub projekty o kontekstowe informacje. - Programistyczne wykonywanie zapytań SPARQL

Pozwól agentom opartym na LLM formułować i wykonywać zapytania SPARQL, umożliwiając odpowiedzi na złożone pytania lub dynamiczne pozyskiwanie uporządkowanej wiedzy. - Eksploracja grafu wiedzy

Umożliwiaj deweloperom eksplorację powiązań między encjami i właściwościami w Wikidata, wspierając badania, analizę danych i przepływy danych powiązanych. - Rekomendacje wspierane przez AI

Buduj agentów AI, którzy mogą rekomendować obiekty (np. filmy danego reżysera) poprzez kombinację wyszukiwania encji, pobierania właściwości i wykonywania zapytań SPARQL.

Jak to skonfigurować

Windsurf

- Upewnij się, że masz zainstalowany Node.js.

- Zlokalizuj plik konfiguracyjny Windsurf.

- Dodaj serwer Wikidata MCP do konfiguracji

mcpServersza pomocą poniższego fragmentu JSON. - Zapisz konfigurację i uruchom ponownie Windsurf.

- Zweryfikuj, że serwer pojawił się w integracjach MCP.

"mcpServers": {

"wikidata-mcp": {

"command": "npx",

"args": ["@zzaebok/mcp-wikidata@latest"]

}

}

Zabezpieczanie kluczy API (jeśli konieczne):

{

"wikidata-mcp": {

"env": {

"WIKIDATA_API_KEY": "twój-klucz-api"

},

"inputs": {

"some_input": "value"

}

}

}

Claude

- Zainstaluj Node.js, jeśli nie jest jeszcze obecny.

- Otwórz plik konfiguracyjny Claude.

- Dodaj poniższą konfigurację dla serwera Wikidata MCP.

- Zapisz i uruchom ponownie Claude Desktop.

- Potwierdź dostępność serwera.

"mcpServers": {

"wikidata-mcp": {

"command": "npx",

"args": ["@zzaebok/mcp-wikidata@latest"]

}

}

Zabezpieczanie kluczy API:

{

"wikidata-mcp": {

"env": {

"WIKIDATA_API_KEY": "twój-klucz-api"

}

}

}

Cursor

- Zainstaluj Node.js i upewnij się, że Cursor obsługuje MCP.

- Edytuj plik konfiguracyjny Cursor.

- Dodaj wpis dla serwera Wikidata MCP jak poniżej.

- Zapisz zmiany i uruchom ponownie Cursor.

- Zweryfikuj, czy serwer jest widoczny.

"mcpServers": {

"wikidata-mcp": {

"command": "npx",

"args": ["@zzaebok/mcp-wikidata@latest"]

}

}

Zabezpieczanie kluczy API:

{

"wikidata-mcp": {

"env": {

"WIKIDATA_API_KEY": "twój-klucz-api"

}

}

}

Cline

- Upewnij się, że Node.js jest zainstalowany.

- Zaktualizuj plik konfiguracyjny Cline, dodając szczegóły serwera MCP.

- Dodaj konfigurację jak poniżej.

- Zapisz i uruchom ponownie Cline.

- Sprawdź integrację serwera MCP.

"mcpServers": {

"wikidata-mcp": {

"command": "npx",

"args": ["@zzaebok/mcp-wikidata@latest"]

}

}

Zabezpieczanie kluczy API:

{

"wikidata-mcp": {

"env": {

"WIKIDATA_API_KEY": "twój-klucz-api"

}

}

}

Jak używać tego MCP w przepływach

Używanie MCP w FlowHunt

Aby zintegrować serwery MCP z przepływem pracy w FlowHunt, zacznij od dodania komponentu MCP do swojego przepływu i połącz go z agentem AI:

Kliknij na komponent MCP, aby otworzyć panel konfiguracji. W sekcji konfiguracji systemowej MCP wklej szczegóły serwera MCP w poniższym formacie JSON:

{

"wikidata-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Po skonfigurowaniu, agent AI może korzystać z MCP jako narzędzia ze wszystkimi jego funkcjami i możliwościami. Pamiętaj, aby zmienić “wikidata-mcp” na faktyczną nazwę swojego serwera MCP oraz podmienić adres URL na własny.

Podsumowanie

| Sekcja | Dostępność | Szczegóły/Uwagi |

|---|---|---|

| Podsumowanie | ✅ | Dostępne podsumowanie w README.md |

| Lista promptów | ⛔ | Brak szablonów promptów |

| Lista zasobów | ⛔ | Brak jawnych zasobów |

| Lista narzędzi | ✅ | Narzędzia opisane w README.md |

| Zabezpieczanie kluczy API | ⛔ | Brak wymogu klucza API wprost |

| Sampling Support (mało istotne w ocenie) | ⛔ | Niewspomniane |

Nasza opinia

Serwer Wikidata MCP to prosta, ale skuteczna implementacja, oferująca kilka przydatnych narzędzi do interakcji z Wikidata za pośrednictwem MCP. Brakuje jednak dokumentacji dotyczącej szablonów promptów, zasobów oraz wsparcia dla sampling/roots, co ogranicza elastyczność w bardziej zaawansowanych lub standaryzowanych integracjach MCP. Obecność licencji, jasnych narzędzi oraz aktywności projektowej sprawia jednak, że jest to solidny punkt wyjścia dla przypadków użycia MCP opartych o Wikidata.

Ocena MCP

| Ma LICENCJĘ | ✅ (MIT) |

|---|---|

| Ma przynajmniej jedno narzędzie | ✅ |

| Liczba forków | 5 |

| Liczba gwiazdek | 18 |

Ocena serwera MCP: 6/10

Solidna podstawowa funkcjonalność, lecz brak wsparcia dla standardowych zasobów/promptów MCP i zaawansowanych funkcji. Dobre rozwiązanie do bezpośrednich integracji z Wikidata.

Najczęściej zadawane pytania

- Czym jest serwer Wikidata MCP?

Serwer Wikidata MCP to implementacja Model Context Protocol, która łączy agentów AI i narzędzia bezpośrednio z API Wikidata. Umożliwia wyszukiwanie encji i właściwości, ekstrakcję metadanych oraz wykonywanie zapytań SPARQL dla zaawansowanego pobierania i wzbogacania danych semantycznych.

- Jakie narzędzia oferuje serwer Wikidata MCP?

Możesz wyszukiwać identyfikatory encji i właściwości, pobierać właściwości encji, ekstraktować etykiety i opisy oraz wykonywać zapytania SPARQL—wszystko przez proste interfejsy narzędzi MCP.

- Jak mogę użyć serwera Wikidata MCP w FlowHunt?

Dodaj komponent MCP do swojego przepływu, skonfiguruj go podając szczegóły serwera Wikidata MCP i połącz z agentem AI. Dzięki temu agent będzie mógł korzystać ze wszystkich narzędzi Wikidata MCP w twoich przepływach pracy.

- Czy do korzystania z serwera Wikidata MCP wymagany jest klucz API?

W większości typowych konfiguracji nie jest wymagany klucz API do dostępu do publicznych danych Wikidata. Jeśli twoje wdrożenie wymaga klucza API (np. dla proxy lub zaawansowanych zastosowań), możesz go podać w konfiguracji środowiska serwera.

- Jakie są praktyczne zastosowania?

Możesz wykorzystać go do pobierania danych semantycznych, wzbogacania metadanych, automatycznych zapytań SPARQL, eksploracji grafów wiedzy oraz budowania rekomendacji AI opartych o strukturalne dane Wikidata.

Zintegruj Wikidata z FlowHunt

Zwiększ możliwości rozumowania i pracy z danymi przez AI, dodając Wikidata jako źródło uporządkowanej wiedzy w swoich przepływach FlowHunt.