A Arte da Otimização de Prompts para Fluxos de Trabalho de IA Mais Inteligentes

Domine a otimização de prompts para IA criando prompts claros e ricos em contexto para aumentar a qualidade dos resultados, reduzir custos e diminuir o tempo de processamento. Explore técnicas para fluxos de trabalho de IA mais inteligentes.

Introdução à Otimização de Prompts

Otimização de prompts significa refinar o input que você fornece a um modelo de IA para que ele entregue as respostas mais precisas e eficientes possíveis. Não se trata apenas de comunicação clara — prompts otimizados também reduzem a sobrecarga computacional, levando a tempos de processamento mais rápidos e custos mais baixos. Seja escrevendo perguntas para chatbots de suporte ao cliente ou gerando relatórios complexos, a forma como você estrutura e formula seus prompts faz diferença.

A Diferença Entre um Bom e um Mau Prompt

Você já tentou pedir para a IA escrever uma meta description? Provavelmente, seu primeiro prompt foi algo assim:

Escreva uma meta description sobre o tema otimização de prompts.

Esse prompt está errado por vários motivos. Se você não especificar o limite de 140 caracteres exigido pelo Google, a IA provavelmente vai ultrapassar. Se acertar o tamanho, frequentemente usará um estilo diferente ou fará uma descrição tão descritiva e sem graça que ninguém vai clicar. Por fim, sem ler o seu artigo, só conseguirá gerar meta descriptions vagas.

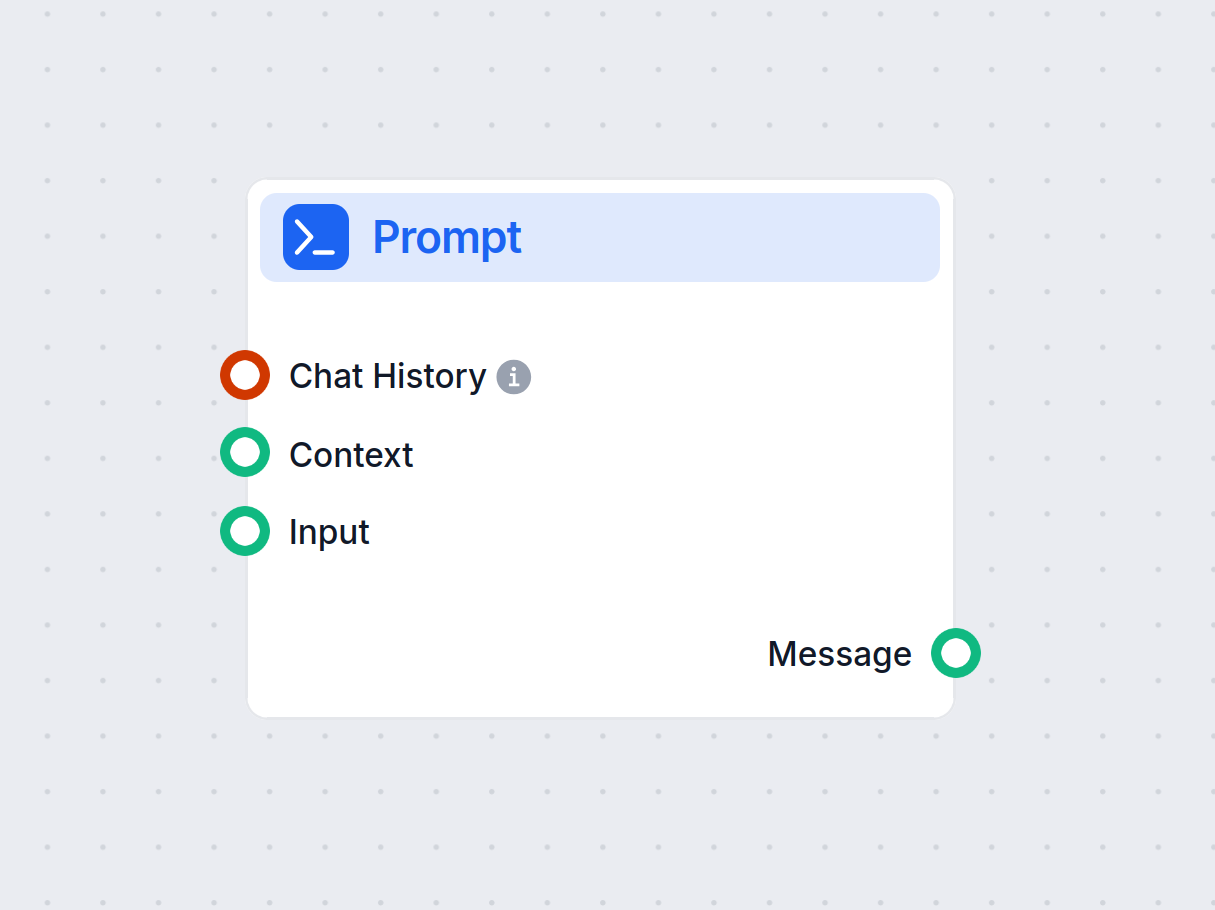

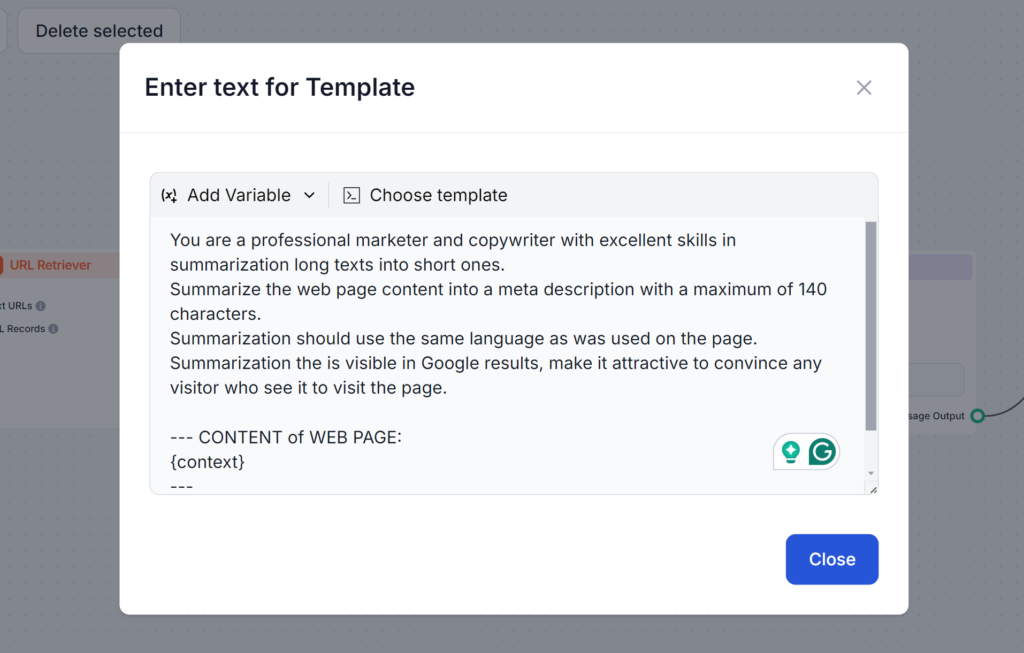

Veja o prompt abaixo. Ele é mais longo e utiliza várias técnicas que vamos aprender neste blog. O que esse prompt faz de bom é abordar todos os possíveis problemas, garantindo que você obtenha exatamente o resultado que precisa logo na primeira tentativa:

Compreendendo o Básico

Tokens são os blocos de construção do texto que os modelos de IA processam. Os modelos quebram o texto nesses tokens. Um único token pode ser uma palavra, mais de uma palavra ou até mesmo uma fração de uma palavra. Mais tokens geralmente significam respostas mais lentas e custos computacionais mais altos. Por isso, entender como os tokens funcionam é essencial para melhorar seus prompts, garantindo que sejam econômicos e rápidos de executar.

Por que os Tokens Importam:

- Custo: Muitos modelos de IA, como o ChatGPT da OpenAI, cobram com base no número de tokens processados.

- Velocidade: Menos tokens levam a respostas mais rápidas.

- Clareza: Um prompt conciso ajuda o modelo a focar nos detalhes relevantes.

Por exemplo:

- Prompt com Muitos Tokens:

Você pode explicar em detalhes todos os aspectos de como modelos de machine learning são treinados, incluindo todos os algoritmos possíveis? - Prompt com Poucos Tokens:

Resuma o processo de treinamento de modelos de machine learning, destacando os principais algoritmos.

No prompt com muitos tokens, a IA é solicitada a detalhar todas as opções possíveis, enquanto o prompt com poucos tokens pede apenas uma visão geral. Vendo a visão geral, você pode expandir conforme sua necessidade, chegando ao resultado desejado de forma mais rápida e barata.

Maneiras de Criar Prompts Eficazes

Criar prompts eficazes requer uma combinação de clareza, contexto e criatividade. Experimentar diferentes formatos é recomendado para descobrir as maneiras mais eficientes de pedir à IA. Aqui estão algumas técnicas essenciais:

Seja Específico e Claro

Prompts ambíguos podem confundir o modelo. Um prompt bem estruturado garante que a IA entenda sua intenção.

Exemplo:

- Prompt Ambíguo:

Escreva sobre esportes. - Prompt Específico:

Escreva um post de 200 palavras sobre os benefícios do exercício regular em jogadores de basquete.

Forneça Contexto

Incluir detalhes relevantes ajuda a IA a gerar respostas alinhadas às suas necessidades.

Exemplo:

- Sem Contexto:

Explique a fotossíntese. - Com Contexto:

Explique a fotossíntese para uma criança de 10 anos usando linguagem simples.

Use Exemplos

Adicionar exemplos orienta a IA sobre o formato ou tom desejado.

Exemplo:

- Sem Exemplo:

Gere uma avaliação de produto para um smartphone. - Com Exemplo:

Escreva uma avaliação positiva de um smartphone assim: “Estou usando o [Nome do Produto] há uma semana e a qualidade da câmera é incrível…”

Experimente com Modelos Prontos

Utilizar modelos padronizados para tarefas semelhantes garante consistência e economiza tempo.

Exemplo de Modelo para Criação de Blog:

“Escreva um post de [quantidade de palavras] sobre [tema], focando em [detalhes específicos]. Use um tom amigável e inclua [palavras-chave].”

Técnicas Avançadas para Otimização de Contexto

Diversas estratégias avançadas podem ajudar você a levar seus prompts para o próximo nível. Essas técnicas vão além da clareza e estrutura básica, permitindo lidar com tarefas mais complexas, integrar dados dinâmicos e adaptar as respostas da IA a domínios ou necessidades específicas. Aqui está um breve resumo de como cada técnica funciona, com exemplos práticos para orientar você.

Few-Shot Learning

Few-shot learning consiste em fornecer alguns exemplos dentro do seu prompt para ajudar a IA a entender o padrão ou formato desejado. Isso permite que o modelo generalize de forma eficaz com poucos dados, sendo ideal para tarefas novas ou desconhecidas.

Basta fornecer alguns exemplos no prompt para ajudar o modelo a compreender suas expectativas.

Exemplo de prompt:

Traduza as seguintes frases para o francês:

- Bom dia → Bonjour

- Como vai você? → Comment ça va?

Agora, traduza: Qual é o seu nome?

Encadeamento de Prompts

O encadeamento de prompts é o processo de dividir tarefas complexas em etapas menores e gerenciáveis, que se apoiam umas nas outras. Esse método permite que a IA resolva problemas em múltiplas etapas de forma sistemática, garantindo clareza e precisão nos resultados.

Exemplo de prompt:

- Etapa 1: Resuma este artigo em 100 palavras.

- Etapa 2: Transforme o resumo em um tweet.

Recuperação Contextual

A recuperação contextual integra informações relevantes e atualizadas ao prompt, referenciando fontes externas ou resumindo detalhes chave. Assim, você dá à IA acesso a dados precisos e atuais para respostas mais informadas.

Exemplo:

“Usando dados deste relatório [inserir link], resuma as principais descobertas sobre tendências em energia renovável [trends.”]

Ajuste Fino com Embeddings

O ajuste fino com embeddings personaliza o modelo de IA para tarefas ou domínios específicos utilizando representações de dados especializadas. Essa customização aumenta a relevância e precisão das respostas em aplicações de nicho ou setores específicos.

Estratégias de Gerenciamento de Tokens

Gerenciar o uso de tokens permite controlar a rapidez e o custo com que a IA lida com inputs e outputs. Ao reduzir o número de tokens processados, você economiza custos e obtém respostas mais rápidas sem sacrificar a qualidade. Confira técnicas para gerenciar tokens de forma eficiente:

- Elimine Palavras Desnecessárias: Evite linguagem redundante ou prolixa. Mantenha os prompts concisos e diretos ao ponto.

- Prolixo: Você poderia, se não se importar, fornecer uma visão geral de…?

- Conciso: Forneça uma visão geral de…

- Use Janela de Processamento: Foque apenas nas seções mais relevantes de inputs longos. Ao dividir em partes gerenciáveis, a IA pode extrair os insights sem revisar o input todo repetidas vezes.

- Exemplo: Extraia pontos-chave de um documento de 10.000 palavras dividindo em seções e pedindo resumos de cada uma.

- Agrupe e Divida Inputs: Ao processar múltiplos prompts, agrupe-os para mais eficiência.

- Exemplo: Combine várias perguntas relacionadas em um único prompt com separadores claros.

Como Monitorar o Desempenho

A otimização não termina na escrita de melhores prompts. Acompanhe regularmente o desempenho e faça iterações baseadas em feedback. Esse acompanhamento contínuo permite refinamento constante, dando a oportunidade de fazer ajustes informados.

Foque nestes pontos principais:

- Precisão das Respostas: Os resultados estão de acordo com o esperado?

- Eficiência: O uso de tokens e os tempos de processamento estão dentro do aceitável?

- Relevância: As respostas estão mantendo o foco no tema?

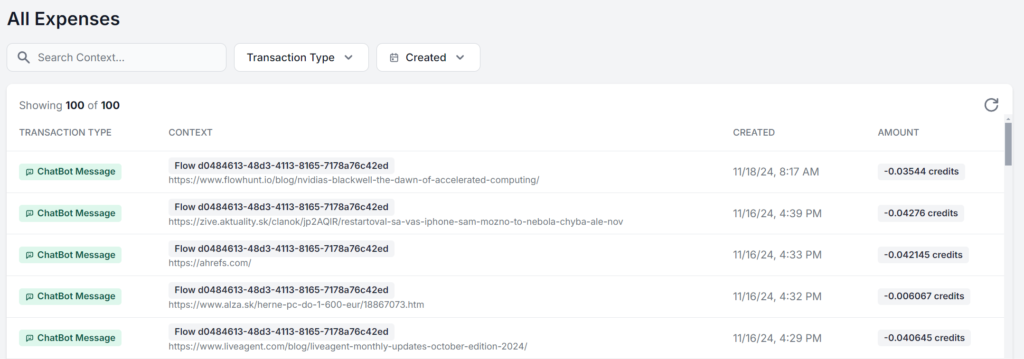

O melhor é trabalhar em uma interface que permita visualizar e analisar o uso exato de cada prompt. Veja o mesmo fluxo de IA do FlowHunt rodando 5 vezes com apenas o material fonte mudando. A diferença entre os custos é de apenas alguns centavos, mas à medida que as cobranças aumentam, a diferença fica logo perceptível:

Conclusão

Seja para aproveitar ao máximo o limite gratuito dos modelos de IA ou construir sua estratégia de IA em escala, a otimização de prompts é fundamental para quem utiliza IA. Essas técnicas permitem usar IA de forma eficiente, obter resultados precisos e reduzir custos.

À medida que a tecnologia de IA avança, a importância de uma comunicação clara e otimizada com os modelos só tende a crescer. Comece a experimentar essas estratégias hoje mesmo, de graça. O FlowHunt permite que você construa com vários modelos e recursos de IA em um único painel, possibilitando fluxos de trabalho de IA otimizados e eficientes para qualquer tarefa. Experimente o teste gratuito de 14 dias!

Perguntas frequentes

- O que é otimização de prompts em IA?

A otimização de prompts envolve refinar o input fornecido a um modelo de IA para que ele entregue respostas mais precisas e eficientes. Prompts otimizados reduzem a sobrecarga computacional, levando a tempos de processamento mais rápidos e custos menores.

- Por que a contagem de tokens importa na engenharia de prompts?

A contagem de tokens afeta tanto a velocidade quanto o custo das respostas da IA. Menos tokens resultam em respostas mais rápidas e custos menores, enquanto prompts concisos ajudam os modelos a focarem nos detalhes relevantes.

- Quais são algumas técnicas avançadas de otimização de prompts?

Técnicas avançadas incluem few-shot learning, encadeamento de prompts, recuperação contextual e ajuste fino com embeddings. Esses métodos ajudam a lidar com tarefas complexas, integrar dados dinâmicos e adaptar respostas a necessidades específicas.

- Como posso medir o desempenho da otimização de prompts?

Monitore a precisão das respostas, o uso de tokens e os tempos de processamento. Acompanhar e iterar regularmente com base no feedback ajuda a refinar os prompts e manter a eficiência.

- Como o FlowHunt pode ajudar na otimização de prompts?

O FlowHunt oferece ferramentas e um painel para construir, testar e otimizar prompts de IA, permitindo que você experimente diferentes modelos e estratégias para fluxos de trabalho de IA eficientes.

Maria é redatora na FlowHunt. Apaixonada por línguas e ativa em comunidades literárias, ela sabe bem que a IA está transformando a forma como escrevemos. Em vez de resistir, busca ajudar a definir o equilíbrio perfeito entre fluxos de trabalho de IA e o valor insubstituível da criatividade humana.

Experimente o FlowHunt para Fluxos de Trabalho de IA Mais Inteligentes

Comece a construir fluxos de trabalho de IA otimizados com o FlowHunt. Experimente engenharia de prompts e aumente sua produtividade.