LLM OpenAI Personalizado

O componente LLM OpenAI Personalizado permite conectar e configurar seus próprios modelos de linguagem compatíveis com OpenAI para fluxos de IA conversacional avançados e flexíveis.

Descrição do componente

Como o componente LLM OpenAI Personalizado funciona

O componente LLM OpenAI Personalizado oferece uma interface flexível para interagir com grandes modelos de linguagem compatíveis com a API da OpenAI. Isso inclui modelos não apenas da OpenAI, mas também de provedores alternativos como JinaChat, LocalAI e Prem. O componente foi projetado para ser altamente configurável, tornando-o adequado para diversos cenários de fluxos de trabalho de IA onde o processamento de linguagem natural é necessário.

Objetivo e Funcionalidade

Este componente atua como uma ponte entre seu fluxo de IA e modelos de linguagem que seguem o padrão de API da OpenAI. Permitindo que você especifique o provedor do modelo, endpoint de API e outros parâmetros, possibilita gerar ou processar texto, chat ou outras saídas baseadas em linguagem dentro do seu fluxo. Seja para resumir conteúdos, responder perguntas, gerar textos criativos ou executar outras tarefas de PLN, este componente pode ser adaptado às suas necessidades.

Configurações

Você pode controlar o comportamento do componente através de vários parâmetros:

| Parâmetro | Tipo | Obrigatório | Padrão | Descrição |

|---|---|---|---|---|

| Max Tokens | int | Não | 3000 | Limita o comprimento máximo da saída de texto gerada. |

| Model Name | string | Não | (vazio) | Especifique o modelo exato a ser usado (ex: gpt-3.5-turbo). |

| OpenAI API Base | string | Não | (vazio) | Permite definir um endpoint de API personalizado (ex: para JinaChat, LocalAI ou Prem). Padrão é OpenAI se vazio. |

| API Key | string | Sim | (vazio) | Sua chave secreta de API para acessar o provedor de modelo de linguagem escolhido. |

| Temperature | float | Não | 0.7 | Controla a criatividade da saída. Valores menores significam resultados mais determinísticos. Faixa: 0 a 1. |

| Use Cache | bool | Não | true | Ative/desative o cache de consultas para melhorar a eficiência e reduzir custos. |

Nota: Todas essas opções de configuração são avançadas, fornecendo controle detalhado sobre o comportamento e a integração do modelo.

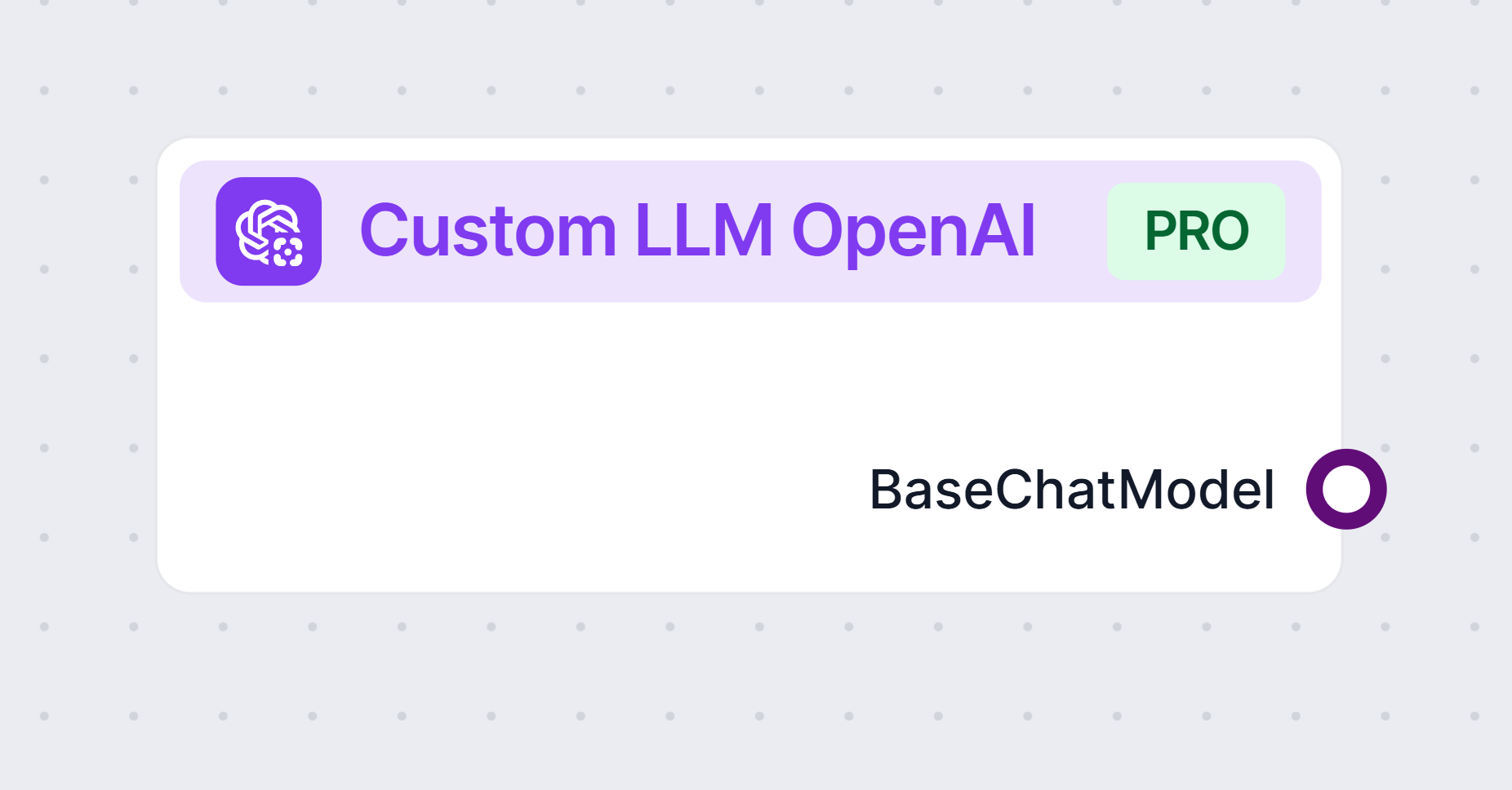

Entradas e Saídas

Entradas:

Não há handles de entrada para este componente.Saídas:

- Produz um objeto

BaseChatModel, que pode ser usado em componentes subsequentes no seu fluxo para processamento ou interação adicional.

- Produz um objeto

Por Que Usar Este Componente?

- Flexibilidade: Conecte-se a qualquer modelo de linguagem compatível com OpenAI, incluindo alternativas de terceiros ou implementações locais.

- Personalização: Ajuste parâmetros como limite de tokens, aleatoriedade (temperature) e cache para se adequar ao seu caso de uso.

- Extensibilidade: Adequado para chatbots, geração de conteúdo, sumarização, geração de código e mais.

- Eficiência: O cache embutido pode evitar consultas redundantes e gerir o uso da API de forma econômica.

Exemplos de Uso

- Implantar um chatbot usando uma instância local de um modelo de linguagem compatível com OpenAI.

- Gerar resumos ou conteúdo criativo usando JinaChat, LocalAI ou um endpoint de API personalizado.

- Integrar análise de texto com LLM em um fluxo de IA maior, conectando saídas a componentes de processamento posteriores.

Tabela Resumo

| Recurso | Descrição |

|---|---|

| Suporte a Provedor | OpenAI, JinaChat, LocalAI, Prem ou qualquer serviço compatível com API OpenAI |

| Tipo de Saída | BaseChatModel |

| Endpoint de API | Configurável |

| Segurança | Chave de API obrigatória (mantida em sigilo) |

| Usabilidade | Configurações avançadas para usuários experientes, mas padrões funcionam para a maioria das aplicações |

Este componente é ideal para quem deseja integrar capacidades de LLM flexíveis, robustas e configuráveis em seus fluxos de trabalho de IA, independentemente de usar OpenAI diretamente ou um provedor alternativo.

Perguntas frequentes

- O que é o componente LLM OpenAI Personalizado?

O componente LLM OpenAI Personalizado permite conectar qualquer modelo de linguagem compatível com OpenAI—como JinaChat, LocalAI ou Prem—fornecendo suas próprias credenciais de API e endpoints, dando controle total sobre as capacidades da sua IA.

- Quais configurações posso personalizar neste componente?

Você pode definir o nome do modelo, chave de API, endpoint de API, temperatura, número máximo de tokens e habilitar o cache de resultados para desempenho e flexibilidade otimizados.

- Posso usar modelos não-OpenAI com este componente?

Sim, desde que o modelo utilize a interface de API da OpenAI, você pode conectar alternativas como JinaChat, LocalAI ou Prem.

- Minha chave de API é segura no FlowHunt?

Sua chave de API é necessária para conectar seu modelo e é tratada com segurança pela plataforma. Ela nunca é compartilhada ou exposta a partes não autorizadas.

- Este componente suporta cache de saída?

Sim, você pode habilitar o cache para armazenar e reutilizar resultados anteriores, reduzindo a latência e o uso da API para consultas repetidas.

Integre LLMs Personalizados ao FlowHunt

Conecte seus próprios modelos de linguagem e potencialize seus fluxos de IA. Experimente hoje o componente LLM OpenAI Personalizado no FlowHunt.