LLM Meta AI

O LLM Meta AI do FlowHunt reúne os modelos Llama da Meta e dezenas de outros modelos de IA em um único painel fácil de controlar para geração flexível de texto e imagem.

Descrição do componente

Como o componente LLM Meta AI funciona

O que é o componente LLM Meta AI?

O componente LLM Meta AI conecta a família de modelos Claude ao seu Flow. Enquanto os Geradores e Agentes são onde a mágica realmente acontece, os componentes LLM permitem controlar o modelo utilizado. Todos os componentes vêm com ChatGPT-4 por padrão. Você pode conectar este componente se desejar alterar o modelo ou ter mais controle sobre ele.

Lembre-se de que conectar um componente LLM é opcional. Todos os componentes que usam um LLM vêm com ChatGPT-4o como padrão. Os componentes LLM permitem que você altere o modelo e controle as configurações do modelo.

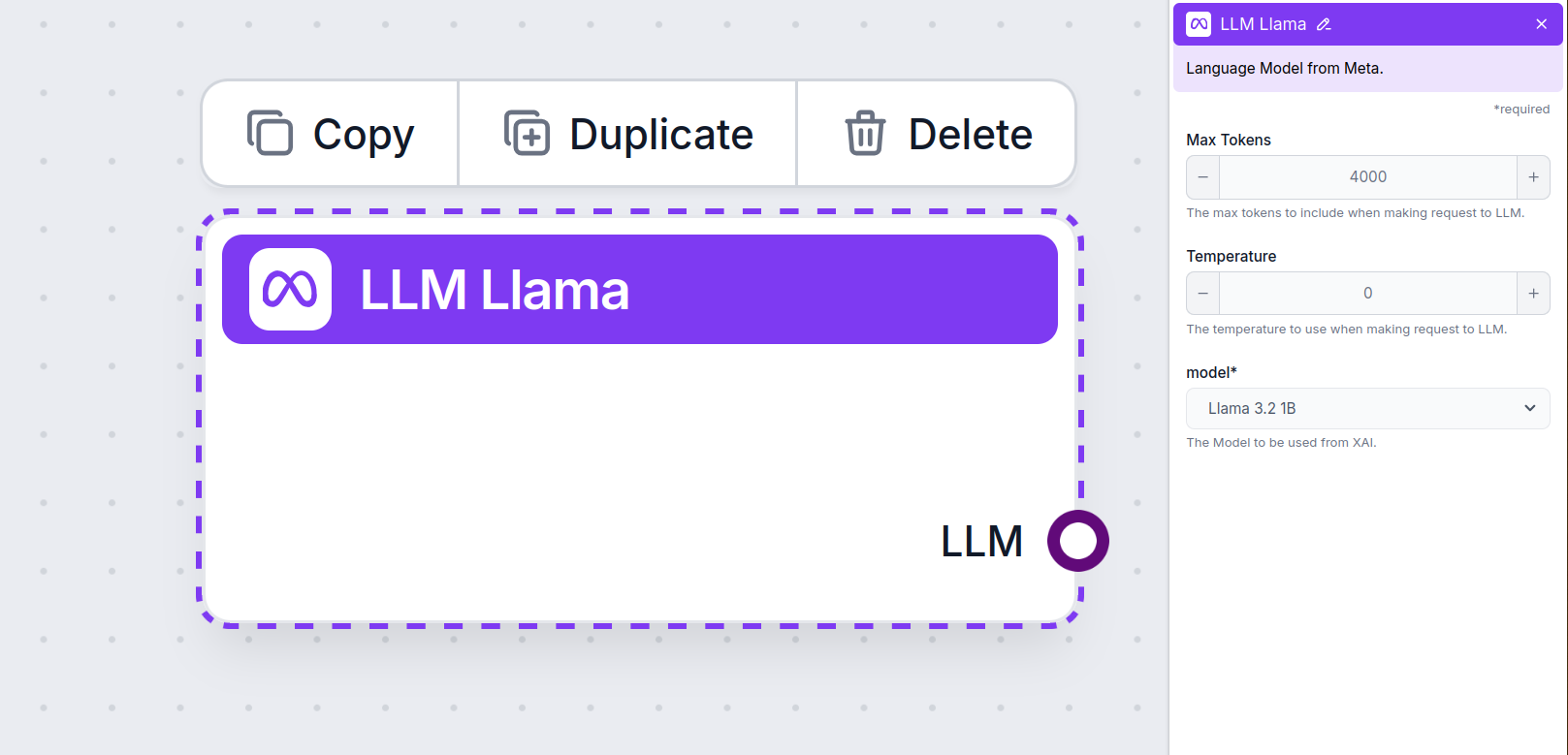

Configurações do Componente LLM Meta AI

Máximo de Tokens

Tokens representam as unidades individuais de texto que o modelo processa e gera. O uso de tokens varia entre modelos, e um único token pode ser qualquer coisa desde uma palavra ou subpalavra até um único caractere. Os modelos geralmente são tarifados por milhões de tokens.

A configuração de máximo de tokens limita o total de tokens que podem ser processados em uma única interação ou requisição, garantindo que as respostas sejam geradas dentro de limites razoáveis. O limite padrão é de 4.000 tokens, o tamanho ideal para resumir documentos e várias fontes para gerar uma resposta.

Temperatura

A temperatura controla a variabilidade das respostas, variando de 0 a 1.

Uma temperatura de 0,1 fará com que as respostas sejam muito objetivas, mas potencialmente repetitivas e pouco criativas.

Uma temperatura alta de 1 permite o máximo de criatividade nas respostas, mas gera o risco de respostas irrelevantes ou até mesmo alucinatórias.

Por exemplo, a temperatura recomendada para um bot de atendimento ao cliente é entre 0,2 e 0,5. Esse nível mantém as respostas relevantes e de acordo com o roteiro, permitindo uma variação natural nas respostas.

Modelo

Este é o seletor de modelos. Aqui você encontrará todos os modelos suportados da Meta AI. Suportamos os modelos Llama leves e de código aberto da Meta. Esses modelos são projetados para implantações eficientes em dispositivos e na borda:

- Llama 3.2 1B – O modelo 1B contém aproximadamente 1,23 bilhão de parâmetros, com um contexto de até 128.000 tokens. O modelo é otimizado para tarefas como sumarização, seguimento de instruções e reescrita, tornando-os adequados para aplicações em dispositivos móveis e embarcados. Saiba mais sobre este modelo e como ele funciona neste artigo.

- Llama 3.2. 3B – O modelo 3B tem cerca de 3,21 bilhões de parâmetros com um contexto de até 128.000 tokens. Saiba mais sobre como este modelo lida com várias tarefas.

Como Adicionar o LLM Meta AI ao Seu Flow

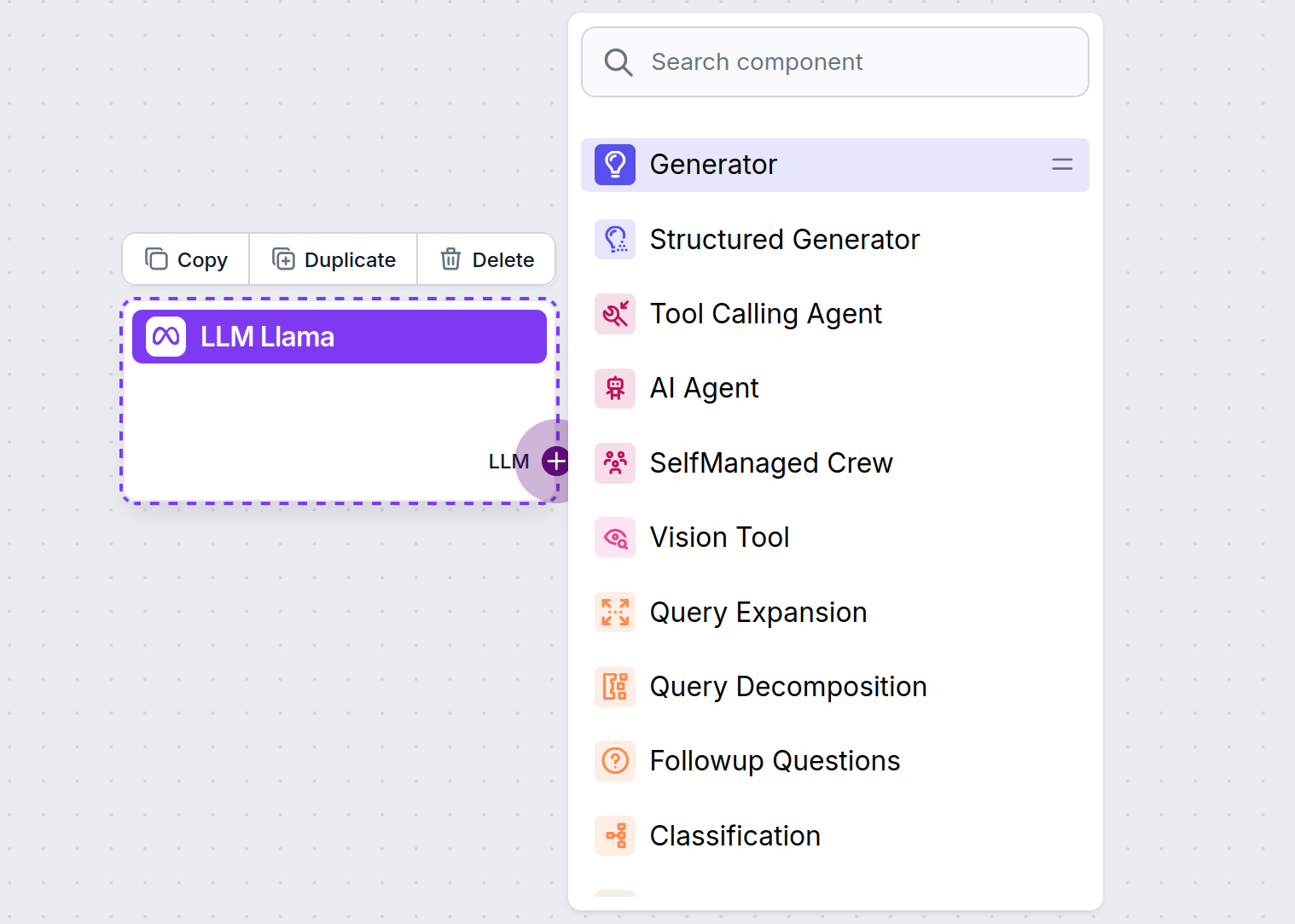

Você notará que todos os componentes LLM possuem apenas uma saída. A entrada não passa pelo componente, pois ele apenas representa o modelo, enquanto a geração propriamente dita ocorre nos Agentes de IA e Geradores.

O conector LLM é sempre roxo. O conector de entrada LLM é encontrado em qualquer componente que utiliza IA para gerar texto ou processar dados. Você pode ver as opções clicando no conector:

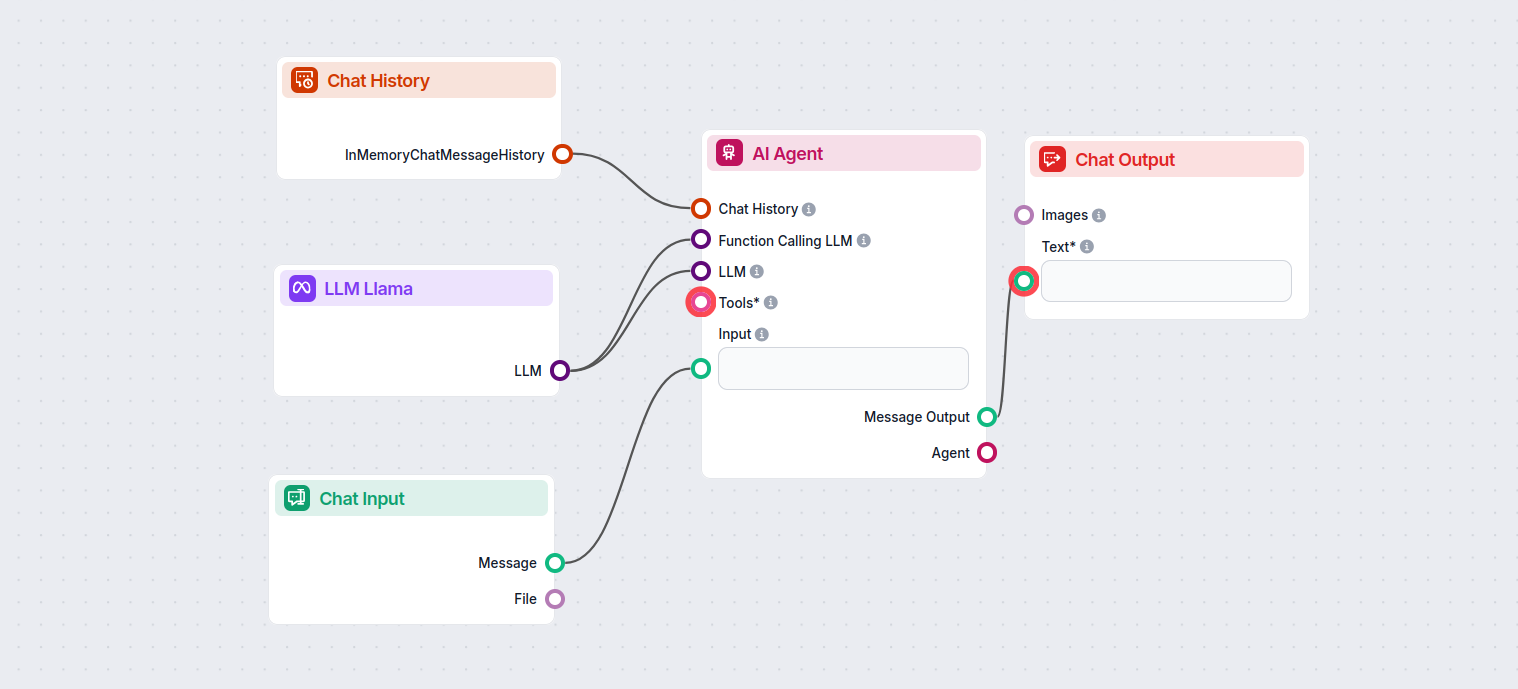

Isso permite criar todo tipo de ferramenta. Veja o componente em ação. Aqui está um fluxo simples de chatbot com Agente de IA usando o Llama 3.2 1B da Meta AI para gerar respostas. Você pode pensar nele como um chatbot Llama básico.

Esse fluxo de Chatbot simples inclui:

- Entrada do chat: Representa a mensagem enviada pelo usuário no chat.

- Histórico do chat: Garante que o chatbot possa lembrar e considerar respostas anteriores.

- Saída do chat: Representa a resposta final do chatbot.

- Agente de IA: Um agente de IA autônomo que gera respostas.

- LLM Meta AI: A conexão com os modelos de geração de texto da Meta.

Perguntas frequentes

- O que é o componente LLM Meta AI no FlowHunt?

O componente LLM Meta AI permite conectar os modelos Llama da Meta e outros geradores de texto/imagem aos seus fluxos, possibilitando fácil seleção de modelos e configuração avançada como máximo de tokens e temperatura.

- Quais modelos da Meta o FlowHunt suporta?

O FlowHunt suporta os modelos Llama de código aberto da Meta, incluindo Llama 3.2 1B e 3B, otimizados para eficiência, sumarização e implantações em dispositivos.

- Como configuro as definições do LLM Meta AI?

Você pode ajustar configurações como máximo de tokens (limita o tamanho da resposta), temperatura (controla a criatividade das respostas) e seleção de modelo diretamente pelo painel do FlowHunt para cada componente.

- É necessário adicionar o componente LLM Meta AI em todo fluxo?

Não, adicionar o componente LLM Meta AI é opcional. Por padrão, os componentes utilizam o ChatGPT-4o, mas você pode trocar para Llama ou outros modelos para mais controle ou casos específicos de uso.

Experimente o LLM Meta AI do FlowHunt

Comece a criar chatbots e ferramentas de IA mais inteligentes com os modelos Llama da Meta e dezenas de outros geradores de IA, tudo em uma única plataforma.