Componente Prompt no FlowHunt

O componente Prompt no FlowHunt especifica funções e comportamentos do bot para respostas de IA personalizadas. Controle a saída com modelos personalizados para criar chatbots eficazes e sensíveis ao contexto.

Descrição do componente

Como o componente Componente Prompt no FlowHunt funciona

Sem um bom prompt, todos os bots agiriam da mesma forma e frequentemente errariam em suas respostas. Prompts fornecem instruções e contexto ao modelo de linguagem, ajudando-o a entender que tipo de texto deve produzir.

Visão Geral do Componente Prompt

O componente Prompt foi projetado para gerar modelos de prompt flexíveis para uso em fluxos de trabalho de IA, permitindo a inserção dinâmica de variáveis e contexto. Este componente é particularmente útil em cenários de IA conversacional, como chatbots ou assistentes virtuais, onde criar prompts adaptáveis e sensíveis ao contexto é essencial.

O que o Componente Faz?

O componente Prompt cria um modelo de prompt que pode incorporar várias variáveis dinâmicas, como entrada do usuário, histórico de chat, instruções do sistema e mensagens de contexto. Ao usar essas variáveis, o componente ajuda você a estruturar prompts ricos e sensíveis ao contexto que aumentam o desempenho e a relevância dos modelos ou agentes de IA subsequentes.

Principais Recursos

- Modelos Dinâmicos: Crie prompts que incluem automaticamente informações disponíveis como histórico de chat, entrada do usuário e contexto.

- Variáveis Personalizadas: Suporta a inserção de variáveis como

{input},{human_input},{context},{chat_history},{system_message}e{all_input_variables}diretamente no modelo de prompt. - Suporte à Mensagem do Sistema: Permite a adição de instruções em nível de sistema para influenciar o comportamento da IA.

- Reutilizável em Fluxos: A saída deste componente pode ser usada como entrada para outros componentes, como LLMs (Modelos de Linguagem de Grande Porte) ou etapas de processamento adicionais.

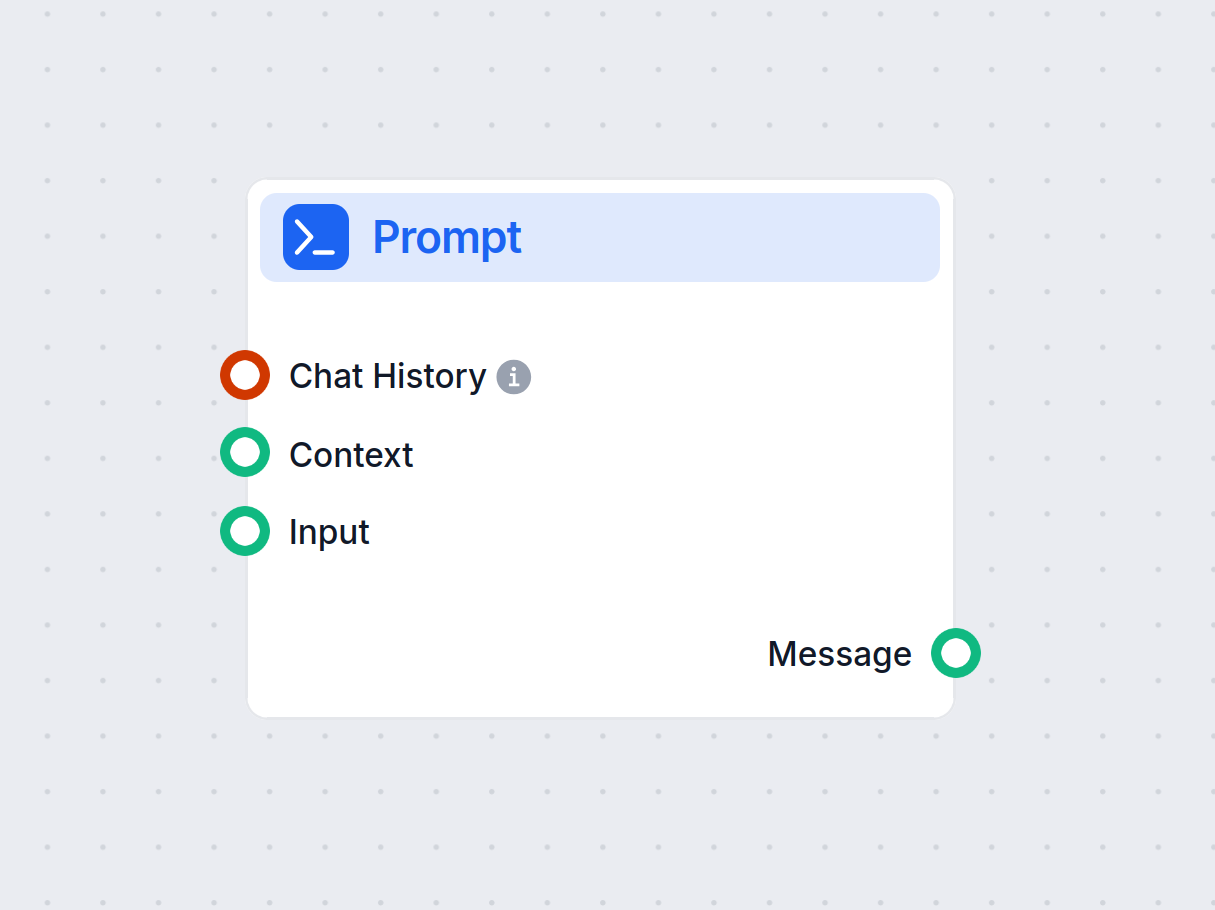

Entradas

As seguintes entradas podem ser fornecidas ao componente Prompt:

| Nome da Entrada | Tipo | Obrigatório | Descrição |

|---|---|---|---|

| Histórico do Chat | InMemoryChatMessageHistory | Não | Mensagens anteriores da conversa. Útil para manter o contexto ou gerar consultas alternativas. |

| Contexto | Message | Não | Informações de contexto adicionais a serem incluídas no prompt. |

| Entrada | Message | Não | A principal entrada ou mensagem do usuário. |

| Mensagem do Sistema | String (multilinha) | Não | Instruções em nível de sistema para guiar o comportamento da IA. |

| Modelo | Prompt (multilinha) | Não | O modelo real do prompt, suportando variáveis dinâmicas para personalização. |

Saídas

- Mensagem:

O componente gera um único objeto de mensagem que contém o prompt construído, com todas as variáveis dinâmicas substituídas por seus respectivos valores.

| Nome da Saída | Tipo | Descrição |

|---|---|---|

| Mensagem | Message | O prompt gerado, pronto para uso em componentes de IA seguintes. |

Exemplos de Uso

- IA Conversacional: Gere automaticamente prompts para chatbots com base na entrada do usuário, histórico da conversa e contexto adicional.

- Geração Aumentada por Recuperação: Personalize prompts para tarefas de recuperação incluindo interações passadas relevantes e instruções do sistema.

- Ajuste de Instrução: Adapte facilmente prompts para diferentes tarefas ou personas ajustando o modelo e a mensagem do sistema.

Por que Usar Este Componente?

- Aprimora a Engenharia de Prompt: Gerencie e atualize facilmente modelos de prompt sem codificação fixa.

- Melhora a Relevância da IA: Ao injetar contexto, mensagens do sistema e histórico, os prompts se tornam mais informativos e precisos.

- Aumenta a Flexibilidade: Suporta uma ampla gama de casos de uso, desde perguntas e respostas simples até conversas complexas de múltiplas etapas.

Tabela Resumo

| Recurso | Benefício |

|---|---|

| Injeção dinâmica de variáveis | Prompts adaptáveis e sensíveis ao contexto |

| Suporte ao histórico de chat | Mantém continuidade em interações de múltiplas etapas |

| Integração de mensagem do sistema | Ajusta personalidade ou instruções da IA |

| Integração fácil em fluxos | Facilita a criação de prompts para IA subsequente |

Este componente é uma ferramenta fundamental para quem constrói fluxos de trabalho de IA sofisticados e sensíveis ao contexto, onde a construção de prompts é fundamental para alcançar resultados de alta qualidade.

Modelo

Esta é uma configuração avançada e opcional. Você pode criar modelos de prompt com variáveis específicas para controlar totalmente a saída do chat. Por exemplo:

Como um especialista em SEO, analise o conteúdo da URL e crie um título com até 65 caracteres.— Conteúdo da URL —{input}Tarefa: Gerar um Título semelhante a outros usando a consulta {human_input}. Não altere {human_input} no novo título. NOVO TÍTULO:

O modelo de prompt padrão se parece com este:

Você é um assistente de modelo de linguagem de IA.

Sua tarefa é gerar uma resposta baseada na consulta de entrada.

Se houver contexto fornecido, use-o para gerar a resposta para as consultas INPUT e HUMAN_INPUT.

Formate a resposta com markdown.

RESPOSTA NO IDIOMA: {lang}

VARIÁVEIS:

{"session_start_time": "2025-06-03 07:35:22", "current_page_url": "https://app.flowhunt.io/aistudio/flows/de6c2e2c-d817-4b2f-af2c-12dba3f46870?ws=74be5f74-d7c5-4076-839d-8ac1771a3b75"}

ENTRADA: {input}

RESPOSTA:

O prompt padrão replica a mesma estrutura das configurações do componente. Você pode substituir as configurações alterando e usando as variáveis no campo do modelo. Criar seus próprios modelos proporciona maior controle sobre a saída.

Como conectar o componente Prompt ao seu fluxo

O prompt é um componente opcional que modifica e especifica ainda mais o resultado final. Ele precisa de vários componentes conectados:

- Histórico do Chat: Conectar o histórico do chat não é obrigatório, mas geralmente é benéfico. Lembrar mensagens anteriores torna as próximas respostas mais relevantes.

- Contexto: Qualquer saída de texto significativa pode servir como contexto. O mais comum é conectar o conhecimento de recuperadores.

- Entrada: Apenas o componente de Entrada de Chat pode ser conectado aqui.

A saída deste componente é um texto que pode ser conectado a vários componentes. Na maioria das vezes, você segue imediatamente com o componente Gerador para conectar o prompt a um LLM.

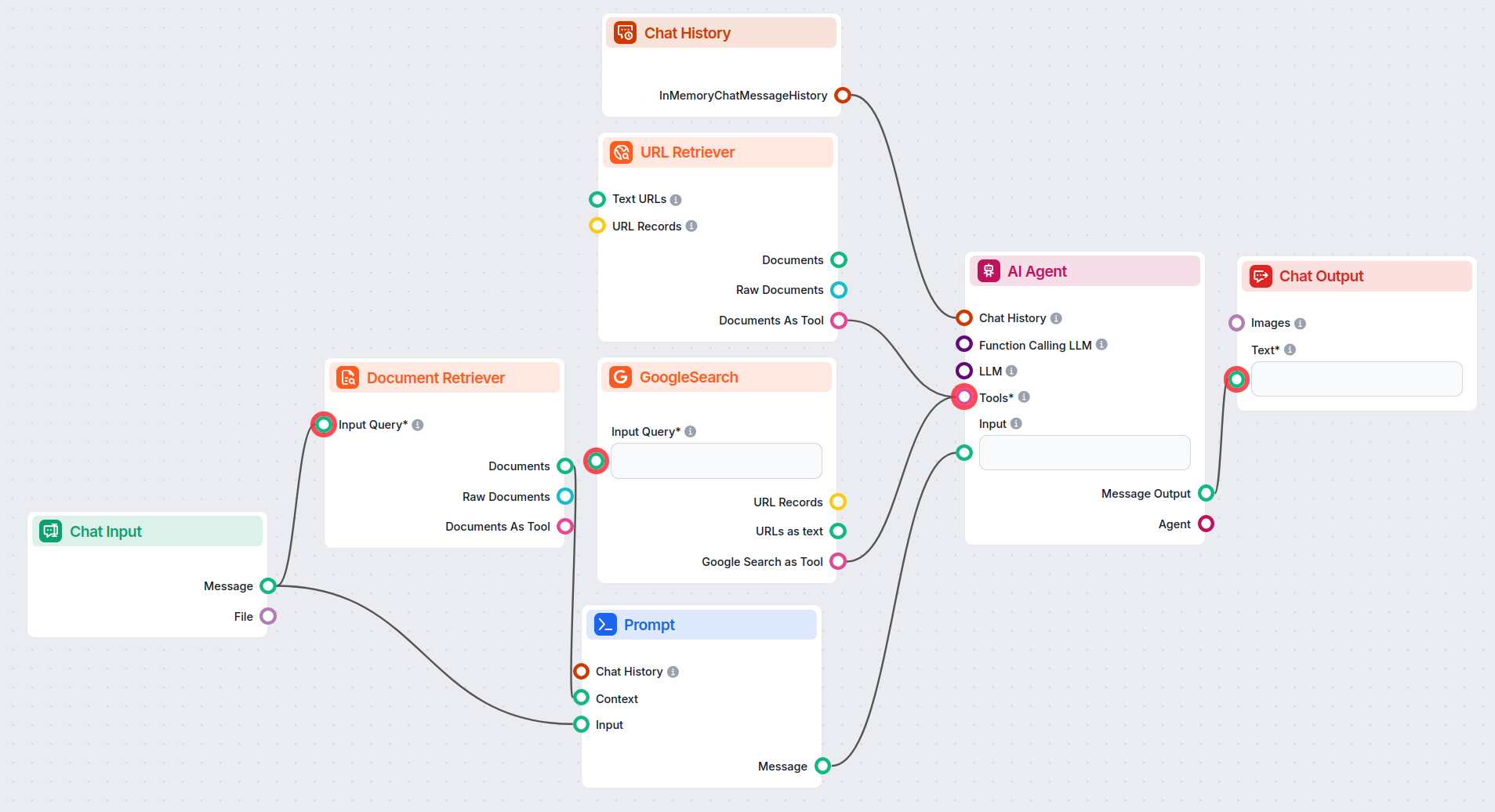

Exemplo

Vamos criar um bot bem simples. Vamos expandir o exemplo do bot cavaleiro medieval mencionado anteriormente. Embora fale de forma engraçada, sua missão principal é ser um bot de atendimento ao cliente útil, e queremos que ele forneça informações relevantes.

Vamos fazer ao nosso bot uma pergunta típica de atendimento ao cliente. Vamos perguntar sobre o preço do URLsLab. Para obter uma resposta bem-sucedida, precisamos:

- Dar contexto: Para os fins deste exemplo, vamos usar o componente de recuperação de URL para fornecer a ele uma página com todas as informações necessárias.

- Conectar entrada: A entrada é sempre a mensagem humana do componente de Entrada de Chat.

- Histórico do Chat: É opcional, mas vamos conectá-lo neste caso específico.

- Modelo: Vamos manter o prompt, “Você é um bot de atendimento ao cliente prestativo que fala como um cavaleiro medieval.”. Os prompts podem ser muito mais elaborados do que isso. Veja nossa biblioteca de prompts para inspiração.

- Adicionar Gerador: Queremos que o bot tenha habilidades conversacionais. Para isso, conecte o Gerador. O Prompt serve como entrada para o gerador.

O fluxo resultante será semelhante a isto:

É hora de testar o conhecimento do nosso bot cavaleiro medieval. A URL que fornecemos contém os preços do URLsLab. Então vamos perguntar sobre isso:

Nosso bot agora usa uma linguagem pomposa da antiguidade para responder perguntas básicas. Mas, mais importante, repare como o bot segue fielmente seu papel central de bot de atendimento ao cliente prestativo. Por fim, ele utiliza com sucesso as informações da URL especificada.

Exemplos de modelos de fluxo usando o componente Componente Prompt no FlowHunt

Para ajudá-lo a começar rapidamente, preparamos vários modelos de fluxo de exemplo que demonstram como usar o componente Componente Prompt no FlowHunt de forma eficaz. Esses modelos apresentam diferentes casos de uso e melhores práticas, tornando mais fácil para você entender e implementar o componente em seus próprios projetos.

Mostrando 61 a 69 de 69 resultados

Perguntas frequentes

- O que é o componente Prompt?

O componente Prompt fornece instruções e contexto ao bot, garantindo que ele responda da maneira desejada.

- Preciso sempre incluir o Prompt nos meus fluxos?

Incluí-lo em muitos casos de uso é uma ótima ideia, mas o componente é opcional.

- O que é a mensagem do sistema?

É um campo de texto editável onde você define a personalidade e o papel do bot. Basta preencher o modelo: 'Você é um(a) {role} que {behavior}.' Por exemplo, 'Você é um bot de atendimento ao cliente prestativo que fala como um cavaleiro medieval.'

- Preciso sempre incluir o Prompt nos meus fluxos?

Certamente é uma ótima ideia incluí-lo em muitos casos de uso, mas o componente é opcional.

Experimente o Componente Prompt do FlowHunt

Comece a construir chatbots de IA personalizados e sensíveis ao contexto com o recurso intuitivo de Prompt do FlowHunt. Defina papéis, comportamentos e controle a saída para automações mais inteligentes.