MCP: Protocolo de Contexto de Modelo

O MCP padroniza o acesso seguro de LLMs a dados, ferramentas e plugins externos, permitindo integração de IA flexível, poderosa e interoperável.

Definição

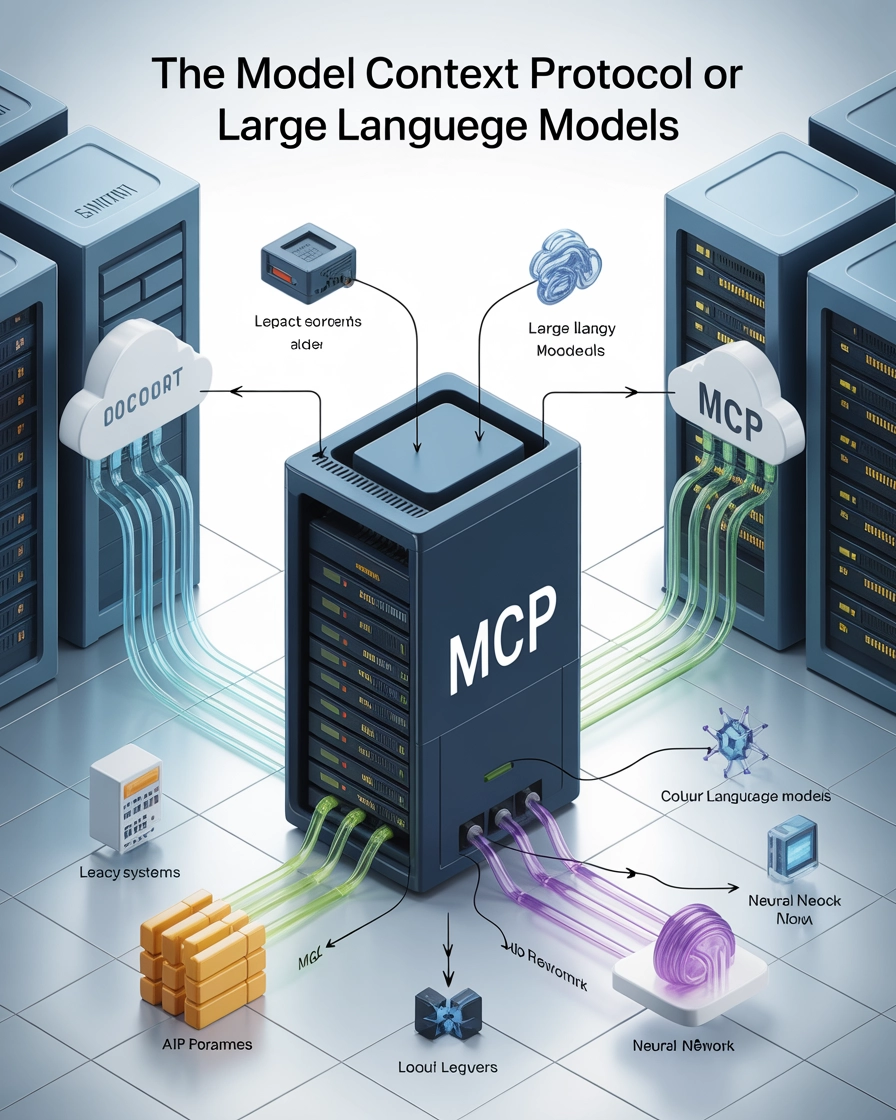

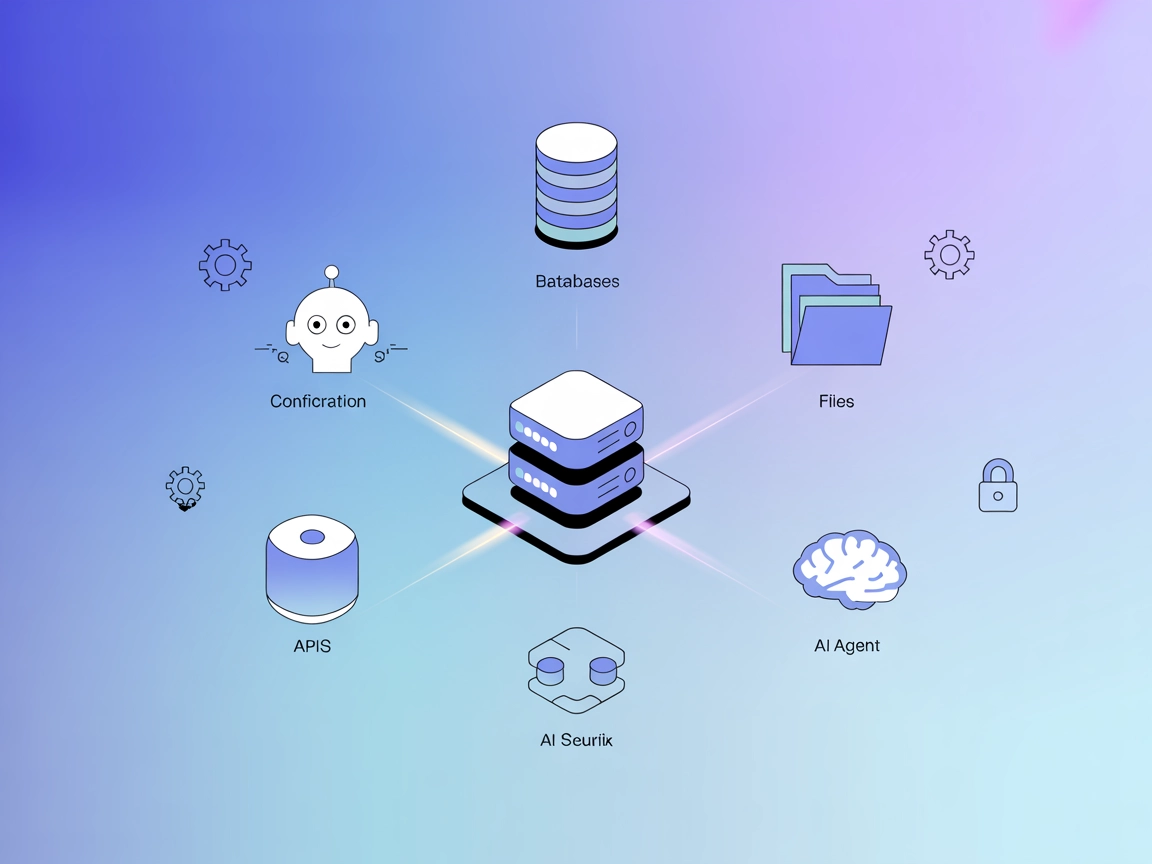

O Protocolo de Contexto de Modelo (MCP) é uma interface aberta e padronizada que permite que Modelos de Linguagem de Grande Porte (LLMs) acessem de forma segura e consistente fontes de dados externas, ferramentas e capacidades. Ele estabelece uma camada de comunicação padronizada entre aplicações de IA e diferentes provedores de contexto, servindo como o “USB-C” para sistemas de IA.

Componentes Principais

Arquitetura

O MCP segue uma arquitetura cliente-servidor:

- Hosts MCP: Aplicações onde usuários ou sistemas de IA interagem (ex.: Claude Desktop, plugins de IDE)

- Clientes MCP: Componentes dentro das aplicações host que gerenciam a comunicação com servidores

- Servidores MCP: Programas leves que expõem capacidades específicas (acesso a arquivos, conexões com bancos de dados, acesso a APIs) por meio da interface padronizada do MCP

- Fontes de Dados: Repositórios de informações locais ou remotos que os servidores MCP podem acessar de forma segura

Primitivas Centrais

O MCP define três primitivas fundamentais que formam os blocos de construção do protocolo:

1. Recursos

Recursos representam dados e conteúdos que servidores MCP disponibilizam para LLMs.

- Características: Controlados pela aplicação, identificados por URIs únicos

- Tipos de Dados: Texto (codificado em UTF-8) ou Binário (codificado em Base64)

- Métodos de Descoberta: Listagem direta ou templates para solicitações dinâmicas de recursos

- Operações: Leitura de conteúdo, recebimento de atualizações

Exemplo de uso: Um servidor MCP expondo um arquivo de log como recurso com URI file:///logs/app.log

2. Prompts

Prompts são templates ou fluxos de trabalho predefinidos que servidores oferecem para orientar as interações dos LLMs.

- Características: Acionados pelo usuário, frequentemente apresentados como comandos de barra

- Estrutura: Nome único, descrição, argumentos opcionais

- Capacidades: Aceitam argumentos de personalização, incorporam contexto de recursos, definem interações de múltiplas etapas

- Operações: Descoberta via listagem, execução sob solicitação

Exemplo de uso: Um prompt gerador de mensagem de commit git que aceita alterações de código como entrada

3. Ferramentas

Ferramentas expõem funções executáveis que LLMs podem invocar (geralmente com aprovação do usuário) para realizar ações.

- Características: Controladas pelo modelo, exigindo esquemas de entrada bem definidos

- Anotações: Incluem dicas sobre o comportamento (somente leitura, destrutivo, idempotente, mundo aberto)

- Recursos de Segurança: Validação de entrada, controle de acesso, avisos claros ao usuário

- Operações: Descoberta via listagem, execução por chamadas com parâmetros

Exemplo de uso: Uma ferramenta de calculadora que realiza operações matemáticas em entradas fornecidas pelo modelo

Importância e Benefícios

Para Desenvolvedores

- Integração Padronizada: Conecte aplicações de IA a diversas fontes de dados sem código personalizado para cada uma

- Boas Práticas de Segurança: Diretrizes embutidas para expor informações sensíveis de forma segura

- Arquitetura Simplificada: Separação clara entre modelos de IA e suas fontes de contexto

Para Usuários e Organizações

- Flexibilidade: Facilita a troca entre diferentes provedores de LLM ou aplicações host

- Interoperabilidade: Reduz o aprisionamento a fornecedores por meio de interfaces padronizadas

- Capacidades Ampliadas: Sistemas de IA ganham acesso a informações e ações mais diversificadas

Exemplos de Implementação

Servidor de Recurso de Arquivo

// Servidor expondo um único arquivo de log como recurso

const server = new Server({ /* config */ }, { capabilities: { resources: {} } });

// Listar recursos disponíveis

server.setRequestHandler(ListResourcesRequestSchema, async () => {

return {

resources: [

{

uri: "file:///logs/app.log",

name: "Logs da Aplicação",

mimeType: "text/plain"

}

]

};

});

// Fornecer conteúdo do recurso

server.setRequestHandler(ReadResourceRequestSchema, async (request) => {

if (request.params.uri === "file:///logs/app.log") {

const logContents = await readLogFile();

return {

contents: [{

uri: request.params.uri,

mimeType: "text/plain",

text: logContents

}]

};

}

throw new Error("Recurso não encontrado");

});

Servidor de Ferramenta Calculadora

const server = new Server({ /* config */ }, { capabilities: { tools: {} } });

// Listar ferramentas disponíveis

server.setRequestHandler(ListToolsRequestSchema, async () => {

return {

tools: [{

name: "calculate_sum",

description: "Soma dois números",

inputSchema: {

type: "object",

properties: {

a: { type: "number", description: "Primeiro número" },

b: { type: "number", description: "Segundo número" }

},

required: ["a", "b"]

},

annotations: {

title: "Calcular Soma",

readOnlyHint: true,

openWorldHint: false

}

}]

};

});

// Lidar com execução da ferramenta

server.setRequestHandler(CallToolRequestSchema, async (request) => {

if (request.params.name === "calculate_sum") {

try {

const { a, b } = request.params.arguments;

if (typeof a !== 'number' || typeof b !== 'number') {

throw new Error("Entrada inválida: 'a' e 'b' devem ser números.");

}

const sum = a + b;

return {

content: [{ type: "text", text: String(sum) }]

};

} catch (error: any) {

return {

isError: true,

content: [{ type: "text", text: `Erro ao calcular a soma: ${error.message}` }]

};

}

}

throw new Error("Ferramenta não encontrada");

});

Conceitos Relacionados

- Chamadas de Função LLM: O Protocolo de Contexto de Modelo fornece uma abordagem padronizada para o conceito de invocação de funções por LLMs

- Agentes de IA: O MCP oferece uma maneira estruturada para sistemas de IA baseados em agentes acessarem ferramentas e informações

- Plugins de IA: Semelhante a extensões de navegador, servidores MCP podem ser vistos como “plugins” que ampliam as capacidades da IA

Direções Futuras

- Integração de IA Corporativa: Conexão de bases de conhecimento corporativas, ferramentas e fluxos de trabalho

- IA Multimodal: Padronização do acesso a tipos diversos de dados além de texto

- Sistemas de IA Colaborativos: Permitir que assistentes de IA trabalhem juntos por meio de protocolos compartilhados

Perguntas frequentes

- O que é o Protocolo de Contexto de Modelo (MCP)?

O MCP é uma interface aberta e padronizada que permite que LLMs acessem de forma segura e consistente fontes de dados externas, ferramentas e capacidades, criando uma camada de comunicação padronizada entre aplicações de IA e provedores de contexto.

- Quais são os principais componentes do MCP?

O MCP é composto por hosts, clientes, servidores e fontes de dados. Ele utiliza primitivas principais—recursos, prompts e ferramentas—para permitir interações flexíveis e seguras entre LLMs e sistemas externos.

- Quais benefícios o MCP oferece para desenvolvedores e organizações?

O MCP simplifica a integração de IA, aumenta a segurança, reduz o aprisionamento a fornecedores e permite acesso contínuo a diferentes informações e ferramentas tanto para desenvolvedores quanto para organizações.

- Como o MCP é implementado em aplicações do mundo real?

O MCP pode ser implementado por meio de servidores que expõem recursos ou ferramentas (por exemplo, acesso a arquivos de log, ferramentas de calculadora) utilizando uma interface padronizada, facilitando conexões com modelos de IA.

- Como o MCP se relaciona com chamadas de função LLM e plugins de IA?

O MCP padroniza o processo de invocação de funções ou ferramentas externas por LLMs, semelhante ao modo como plugins ampliam as capacidades de navegadores ou softwares.

Experimente o FlowHunt e Construa Suas Próprias Soluções de IA

Comece a construir sistemas de IA poderosos com integrações padronizadas, acesso seguro a dados e conectividade flexível de ferramentas usando o FlowHunt.