Chat MCP Server

Um cliente MCP limpo e educativo para interagir com múltiplos LLMs por meio de uma interface de chat desktop unificada, perfeito para aprendizado, prototipagem e desenvolvimento.

O que o servidor MCP “Chat MCP” faz?

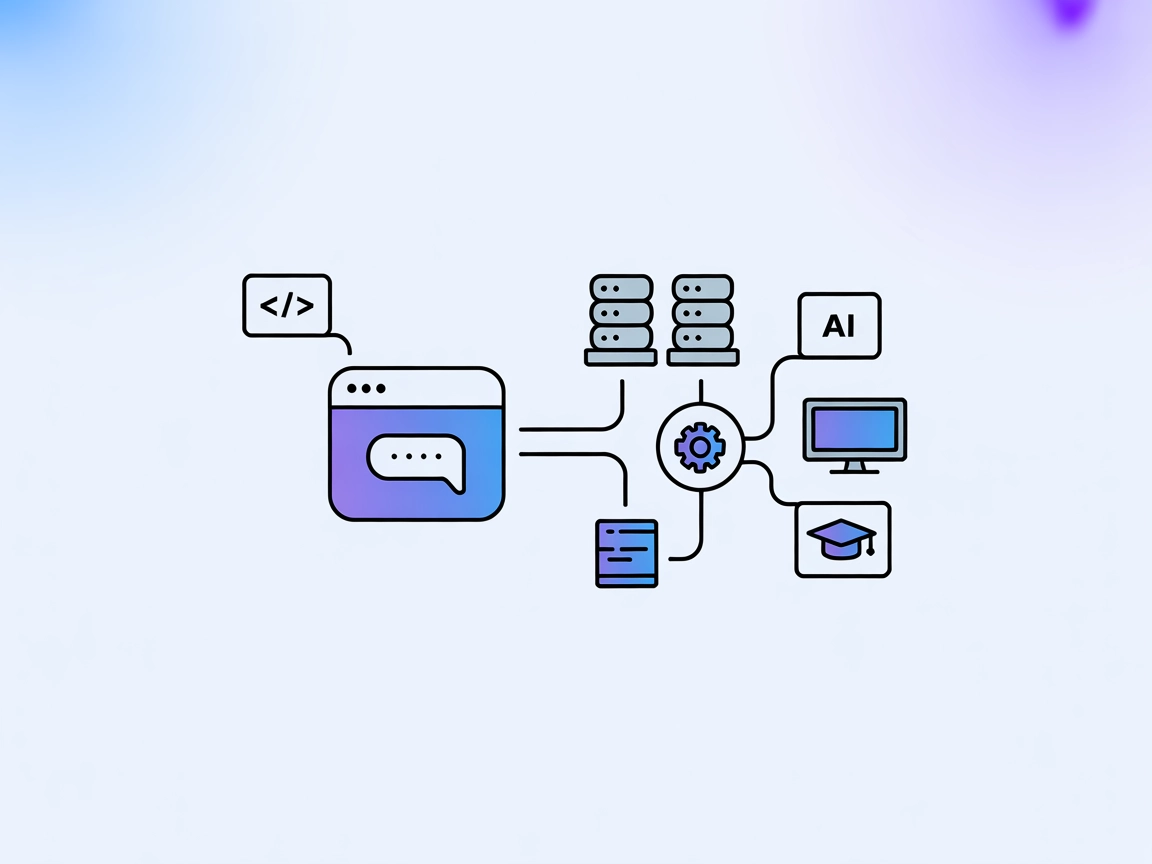

O Chat MCP é um aplicativo de chat desktop que utiliza o Model Context Protocol (MCP) para se conectar a diversos Large Language Models (LLMs). Construído com Electron para compatibilidade multiplataforma, o Chat MCP permite que usuários conectem e gerenciem múltiplos backends de LLM, oferecendo uma interface unificada para testar, interagir e configurar diferentes modelos de IA. Seu código minimalista foi projetado para ajudar desenvolvedores e pesquisadores a entender os princípios centrais do MCP, prototipar rapidamente com diferentes servidores e otimizar fluxos de trabalho que envolvem LLMs. Os principais recursos incluem configuração dinâmica de LLMs, gerenciamento multi-cliente e fácil adaptação tanto para ambientes desktop quanto web.

Lista de Prompts

Nenhum template de prompt é mencionado na documentação disponível ou nos arquivos do repositório.

Lista de Recursos

Nenhum recurso MCP explícito está documentado no repositório ou em exemplos de configuração.

Lista de Ferramentas

Nenhuma ferramenta específica é listada ou descrita no repositório ou server.py (o repositório não contém um arquivo server.py nem definições equivalentes de ferramentas).

Casos de Uso deste Servidor MCP

Plataforma Unificada de Teste de LLM

O Chat MCP permite que desenvolvedores configurem e testem rapidamente múltiplos provedores e modelos de LLM em uma única interface, agilizando o processo de avaliação.Aplicativo de Chat IA Multiplataforma

Ao suportar Linux, macOS e Windows, o Chat MCP pode ser utilizado como um cliente de chat desktop para interagir com modelos de IA em qualquer sistema operacional principal.Desenvolvimento e Depuração de Integrações MCP

Com seu código limpo, desenvolvedores podem usar o Chat MCP como referência ou ponto de partida para construir ou depurar suas próprias aplicações compatíveis com MCP.Ferramenta Educacional para MCP

A abordagem minimalista do projeto o torna ideal para aprender sobre o Model Context Protocol e experimentar conexões com LLMs.

Como configurar

Windsurf

- Instale o Node.js: Baixe e instale o Node.js em nodejs.org.

- Clone o repositório:

git clone https://github.com/AI-QL/chat-mcp.git - Edite a configuração:

Modifiquesrc/main/config.jsoncom os detalhes da sua API de LLM e configurações MCP. - Instale as dependências:

npm install - Inicie o app:

npm start

Exemplo de configuração JSON:

{

"chatbotStore": {

"apiKey": "",

"url": "https://api.aiql.com",

"path": "/v1/chat/completions",

"model": "gpt-4o-mini",

"mcp": true

}

}

Nota: Proteja suas chaves de API usando variáveis de ambiente ou armazenamento criptografado (não suportado diretamente na configuração fornecida, mas recomendado).

Claude

- Instale o Node.js: Obtenha o Node.js em nodejs.org.

- Baixe/clone o Chat MCP.

- Edite

src/main/config.jsoncom o endpoint e detalhes compatíveis com a API do Claude. - Execute

npm install. - Inicie com

npm start.

Exemplo de JSON:

{

"chatbotStore": {

"apiKey": "",

"url": "https://anthropic.api.endpoint",

"path": "/v1/messages",

"model": "claude-3-opus",

"mcp": true

}

}

Nota: Utilize variáveis de ambiente para dados sensíveis.

Cursor

- Instale o Node.js.

- Clone o repositório Chat MCP.

- Atualize

src/main/config.jsonpara o backend do Cursor. - Instale as dependências.

- Inicie o aplicativo.

Exemplo de JSON:

{

"chatbotStore": {

"apiKey": "",

"url": "https://cursor.api.endpoint",

"path": "/v1/chat/completions",

"model": "cursor-model",

"mcp": true

}

}

Nota: Use variáveis de ambiente para as chaves de API.

Cline

- Instale o Node.js.

- Clone o repositório.

- Edite

src/main/config.jsoncom os detalhes da API do Cline. - Execute

npm install. - Inicie com

npm start.

Exemplo de JSON:

{

"chatbotStore": {

"apiKey": "",

"url": "https://cline.api.endpoint",

"path": "/v1/chat/completions",

"model": "cline-model",

"mcp": true

}

}

Nota: Proteja as chaves de API utilizando variáveis de ambiente.

Exemplo de proteção de chaves de API:

{

"chatbotStore": {

"apiKey": "${API_KEY}",

"url": "https://api.example.com",

"path": "/v1/chat/completions",

"model": "your-model",

"mcp": true

}

}

Defina a variável de ambiente API_KEY antes de iniciar o aplicativo.

Como usar este MCP em fluxos

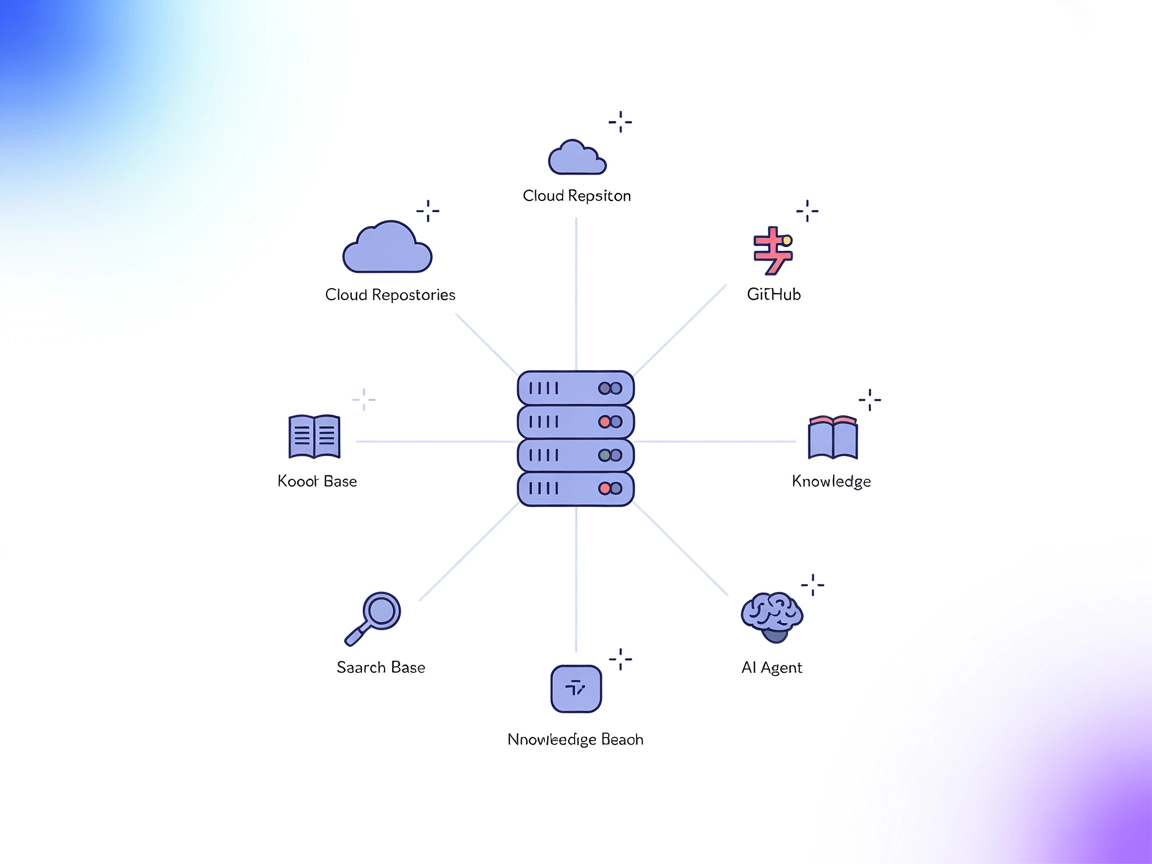

Usando MCP no FlowHunt

Para integrar servidores MCP ao seu fluxo de trabalho no FlowHunt, comece adicionando o componente MCP ao seu fluxo e conectando-o ao seu agente de IA:

Clique no componente MCP para abrir o painel de configuração. Na seção de configuração do sistema MCP, insira os detalhes do seu servidor MCP neste formato JSON:

{

"chat-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Após configurado, o agente de IA poderá usar este MCP como uma ferramenta com acesso a todas as suas funções e capacidades. Lembre-se de trocar “chat-mcp” pelo nome real do seu servidor MCP e substituir a URL pela URL do seu servidor.

Visão Geral

| Seção | Disponibilidade | Detalhes/Notas |

|---|---|---|

| Visão Geral | ✅ | |

| Lista de Prompts | ⛔ | Nenhum template de prompt documentado |

| Lista de Recursos | ⛔ | Nenhum recurso MCP documentado |

| Lista de Ferramentas | ⛔ | Nenhuma ferramenta listada |

| Proteção de Chaves de API | ✅ | Recomendado; não suportado nativamente, mas aconselhável |

| Suporte a Sampling (menos importante na avaliação) | ⛔ | Nenhuma menção a suporte a sampling |

Com base nas informações disponíveis, o Chat MCP é um cliente MCP simples, educacional e flexível, mas carece de recursos MCP avançados (ferramentas, recursos, sampling, roots) em sua documentação pública e configuração. Seu principal valor está em ser uma interface de chat limpa e facilmente modificável. No geral, é um bom ponto de partida para aprendizado de MCP ou como base para integrações mais avançadas.

Pontuação MCP

| Possui uma LICENÇA | ✅ Apache-2.0 |

|---|---|

| Possui pelo menos uma ferramenta | ⛔ |

| Número de Forks | 31 |

| Número de Stars | 226 |

Perguntas frequentes

- O que é o Chat MCP?

O Chat MCP é um aplicativo de chat desktop multiplataforma construído com Electron, projetado para conectar-se a diversos backends de LLM usando o Model Context Protocol (MCP). Ele fornece uma interface unificada para prototipagem, testes e configuração de LLMs.

- Quais são os principais casos de uso do Chat MCP?

O Chat MCP é ideal para testes de LLM, depuração de integrações MCP, aprendizado dos princípios do MCP e como referência limpa de implementação ou base para ferramentas de chat mais avançadas.

- Como proteger minhas chaves de API no Chat MCP?

Embora a configuração padrão do Chat MCP use texto simples, recomenda-se definir valores sensíveis como chaves de API em variáveis de ambiente e referenciá-las na sua configuração.

- O Chat MCP suporta recursos MCP avançados como ferramentas e recursos?

Não, a documentação pública e o código-fonte não incluem recursos MCP avançados como ferramentas ou recursos. O Chat MCP foca em fornecer uma interface de chat minimalista e extensível para LLMs.

- Posso usar o Chat MCP com o FlowHunt?

Sim. O Chat MCP pode ser integrado como um servidor MCP dentro do FlowHunt ao adicionar o componente MCP ao seu fluxo e configurá-lo usando os detalhes do servidor em formato JSON. Veja a documentação para as etapas exatas.

Experimente o Chat MCP com FlowHunt

Explore e interaja com múltiplos LLMs usando o Chat MCP. Perfeito para aprendizado do MCP, prototipagem rápida e experiências de chat unificadas.