Servidor Deepseek R1 MCP

Integre os modelos otimizados para contexto e raciocínio da DeepSeek nos seus fluxos de trabalho de IA com o Servidor Deepseek R1 MCP para tarefas linguísticas avançadas e automação.

O que faz o Servidor “Deepseek R1” MCP?

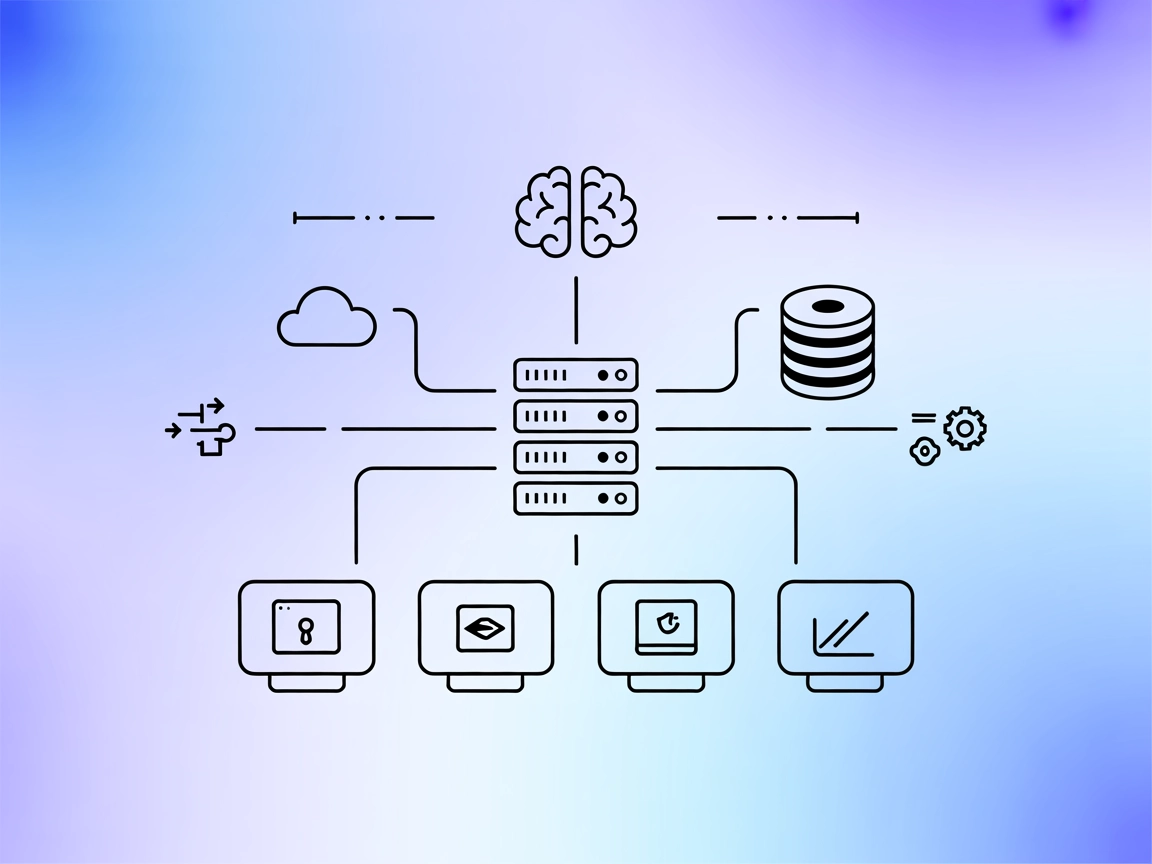

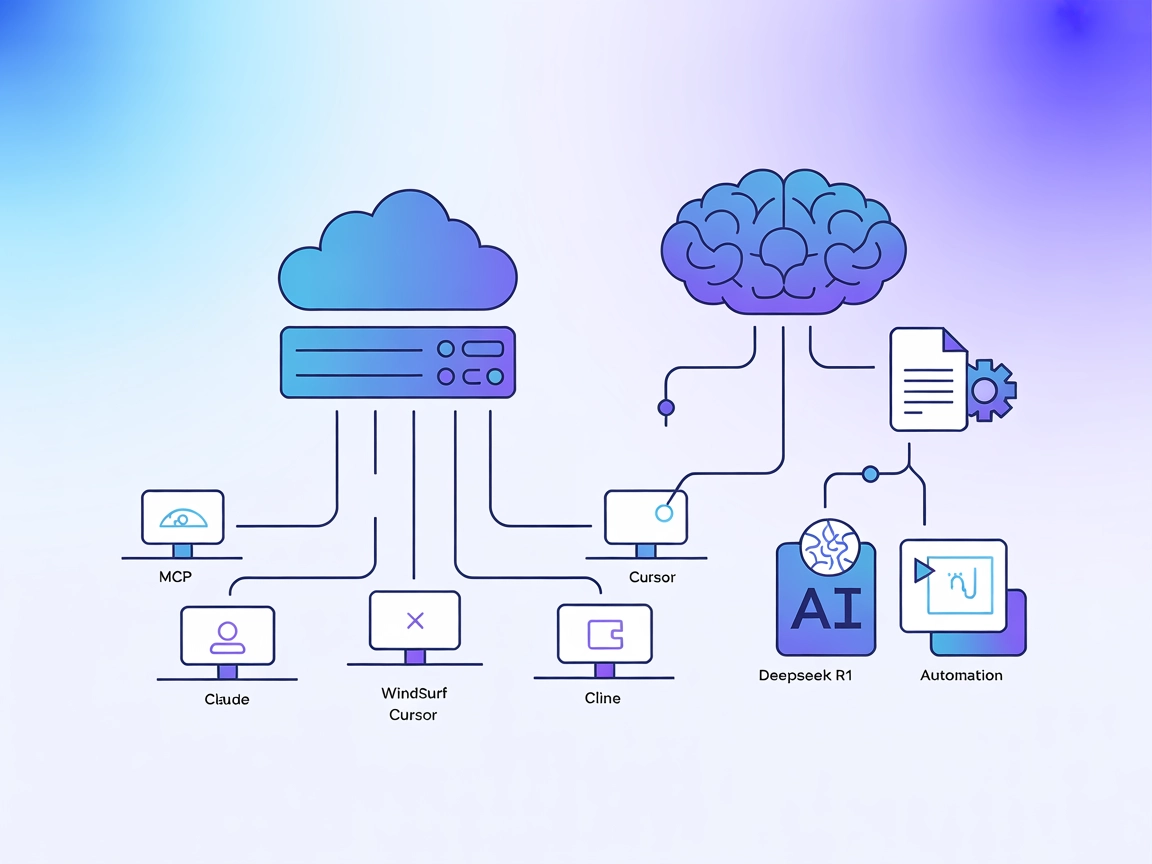

O Servidor Deepseek R1 MCP é uma implementação do Model Context Protocol (MCP) projetada para conectar o Claude Desktop aos avançados modelos de linguagem da DeepSeek, como Deepseek R1 e DeepSeek V3. Atuando como ponte entre assistentes de IA e os poderosos modelos otimizados para raciocínio da DeepSeek (com janela de contexto de 8192 tokens), este servidor permite que agentes de IA executem tarefas aprimoradas de compreensão e geração de linguagem natural. Desenvolvedores podem usar o Servidor Deepseek R1 MCP para integrar esses modelos perfeitamente em seus fluxos de trabalho, facilitando geração avançada de texto, raciocínio e interação com fontes de dados externas ou APIs nas plataformas suportadas. A implementação prioriza fornecer integração estável, confiável e eficiente usando Node.js/TypeScript para compatibilidade e segurança de tipos ideais.

Lista de Prompts

Nenhum modelo de prompt está documentado no repositório.

Lista de Recursos

Nenhum recurso MCP explícito está documentado no repositório.

Lista de Ferramentas

- Ferramenta avançada de geração de texto

- Permite que LLMs gerem texto usando Deepseek R1 (ou V3), aproveitando a grande janela de contexto e as capacidades de raciocínio do modelo.

Casos de Uso deste Servidor MCP

- Geração Avançada de Texto

Aproveite a grande janela de contexto do DeepSeek R1 (8192 tokens) para compor saídas longas e complexas para documentação, narrativas ou escrita técnica. - Tarefas de Raciocínio Aprimoradas

Use as capacidades otimizadas do modelo Deepseek R1 para raciocínio lógico ou de múltiplas etapas, ideal para resolução de problemas e análise. - Integração Transparente com Claude Desktop

Integre modelos de linguagem de ponta diretamente em ambientes Claude Desktop, ampliando as capacidades do assistente de IA para fluxos de trabalho diários. - Seleção Flexível de Modelo

Alterne entre os modelos Deepseek R1 e DeepSeek V3 modificando a configuração, adaptando-se a diferentes requisitos de projeto. - Automação via API

Permita automação orientada por IA em ambientes onde a API da DeepSeek está disponível, otimizando a criação de conteúdo ou a gestão de bases de conhecimento.

Como configurar

Windsurf

- Certifique-se de que Node.js (v18+) e npm estão instalados.

- Clone o repositório e instale as dependências:

git clone https://github.com/66julienmartin/MCP-server-Deepseek_R1.git cd deepseek-r1-mcp npm install - Copie

.env.exemplepara.enve defina sua chave de API da DeepSeek. - Edite a configuração do Windsurf para adicionar o servidor MCP:

{ "mcpServers": { "deepseek_r1": { "command": "node", "args": ["/path/to/deepseek-r1-mcp/build/index.js"], "env": { "DEEPSEEK_API_KEY": "your-api-key" } } } } - Salve, reinicie o Windsurf e verifique se o servidor está rodando.

Claude

- Instale Node.js (v18+) e npm.

- Clone e configure o Servidor Deepseek R1 MCP como acima.

- Na configuração do Claude, adicione:

{ "mcpServers": { "deepseek_r1": { "command": "node", "args": ["/path/to/deepseek-r1-mcp/build/index.js"], "env": { "DEEPSEEK_API_KEY": "your-api-key" } } } } - Reinicie o Claude e verifique a disponibilidade do servidor MCP.

Cursor

- Instale os pré-requisitos (Node.js, npm).

- Configure o servidor e as variáveis de ambiente.

- Adicione o servidor na configuração do Cursor:

{ "mcpServers": { "deepseek_r1": { "command": "node", "args": ["/path/to/deepseek-r1-mcp/build/index.js"], "env": { "DEEPSEEK_API_KEY": "your-api-key" } } } } - Salve, reinicie o Cursor e teste a integração do servidor.

Cline

- Certifique-se de que Node.js e npm estão instalados.

- Clone e construa o Servidor Deepseek R1 MCP.

- Adicione o servidor na configuração do Cline:

{ "mcpServers": { "deepseek_r1": { "command": "node", "args": ["/path/to/deepseek-r1-mcp/build/index.js"], "env": { "DEEPSEEK_API_KEY": "your-api-key" } } } } - Reinicie o Cline e confirme que o servidor MCP está conectado.

Protegendo as Chaves de API

Use variáveis de ambiente na configuração para manter as chaves de API seguras:

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

Como usar este MCP em fluxos

Usando MCP no FlowHunt

Para integrar servidores MCP em seu fluxo FlowHunt, comece adicionando o componente MCP ao seu fluxo e conectando-o ao seu agente de IA:

Clique no componente MCP para abrir o painel de configuração. Na seção de configuração MCP do sistema, insira os detalhes do seu servidor MCP usando este formato JSON:

{

"deepseek_r1": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Uma vez configurado, o agente de IA poderá usar este MCP como ferramenta, com acesso a todas as suas funções e capacidades. Lembre-se de alterar “deepseek_r1” para o nome real do seu servidor MCP e substituir a URL pela URL do seu servidor.

Visão Geral

| Seção | Disponível | Detalhes/Notas |

|---|---|---|

| Visão Geral | ✅ | |

| Lista de Prompts | ⛔ | Nenhum modelo de prompt documentado |

| Lista de Recursos | ⛔ | Nenhum recurso MCP explícito documentado |

| Lista de Ferramentas | ✅ | Ferramenta avançada de geração de texto |

| Protegendo as Chaves de API | ✅ | Use variáveis de ambiente na configuração |

| Suporte a Sampling (menos relevante na avaliação) | ⛔ | Não documentado |

| Suporta Roots | ⛔ | Não documentado |

Com base na documentação disponível, o Servidor Deepseek R1 MCP oferece uma implementação limpa e focada, de fácil configuração e uso, mas carece de documentação para prompts, recursos ou recursos MCP avançados como roots e sampling. Isso o torna altamente prático para geração de texto, mas menos completo para fluxos de trabalho mais complexos.

Pontuação MCP

| Possui LICENSE | ✅ (MIT) |

|---|---|

| Possui pelo menos uma ferramenta | ✅ |

| Número de Forks | 12 |

| Número de Stars | 58 |

Perguntas frequentes

- O que é o Servidor Deepseek R1 MCP?

É um servidor Model Context Protocol (MCP) que atua como ponte entre o Claude Desktop (ou outras plataformas) e os avançados modelos de linguagem da DeepSeek (R1, V3), permitindo geração de texto aprimorada, raciocínio e automação em seus fluxos de trabalho de IA.

- Quais modelos são suportados?

O servidor suporta Deepseek R1 e DeepSeek V3—ambos otimizados para grandes janelas de contexto e tarefas de raciocínio complexo.

- Quais são os principais casos de uso?

Incluem geração avançada de texto (longo, técnico ou criativo), raciocínio lógico, aprimoramento de assistentes de IA no Claude Desktop e automação de criação de conteúdo ou gestão de conhecimento via API.

- Como proteger minhas chaves de API?

Sempre utilize variáveis de ambiente na configuração do servidor MCP para evitar exposição acidental de sua chave DeepSeek API.

- Suporta modelos de prompt ou recursos?

Não há modelos de prompt nem recursos MCP explícitos documentados no repositório; o foco do servidor é acesso direto ao modelo e integração.

- Qual o tamanho da janela de contexto?

O DeepSeek R1 oferece uma janela de contexto de 8192 tokens, permitindo lidar com tarefas longas e complexas.

- O projeto é open source?

Sim, é licenciado sob MIT e disponível no GitHub.

Potencialize sua IA com o Deepseek R1

Desbloqueie geração avançada de texto e raciocínio conectando o FlowHunt ou Claude Desktop aos poderosos modelos DeepSeek R1. Comece a construir fluxos de trabalho mais inteligentes hoje.