Servidor MCP do VertexAI Search

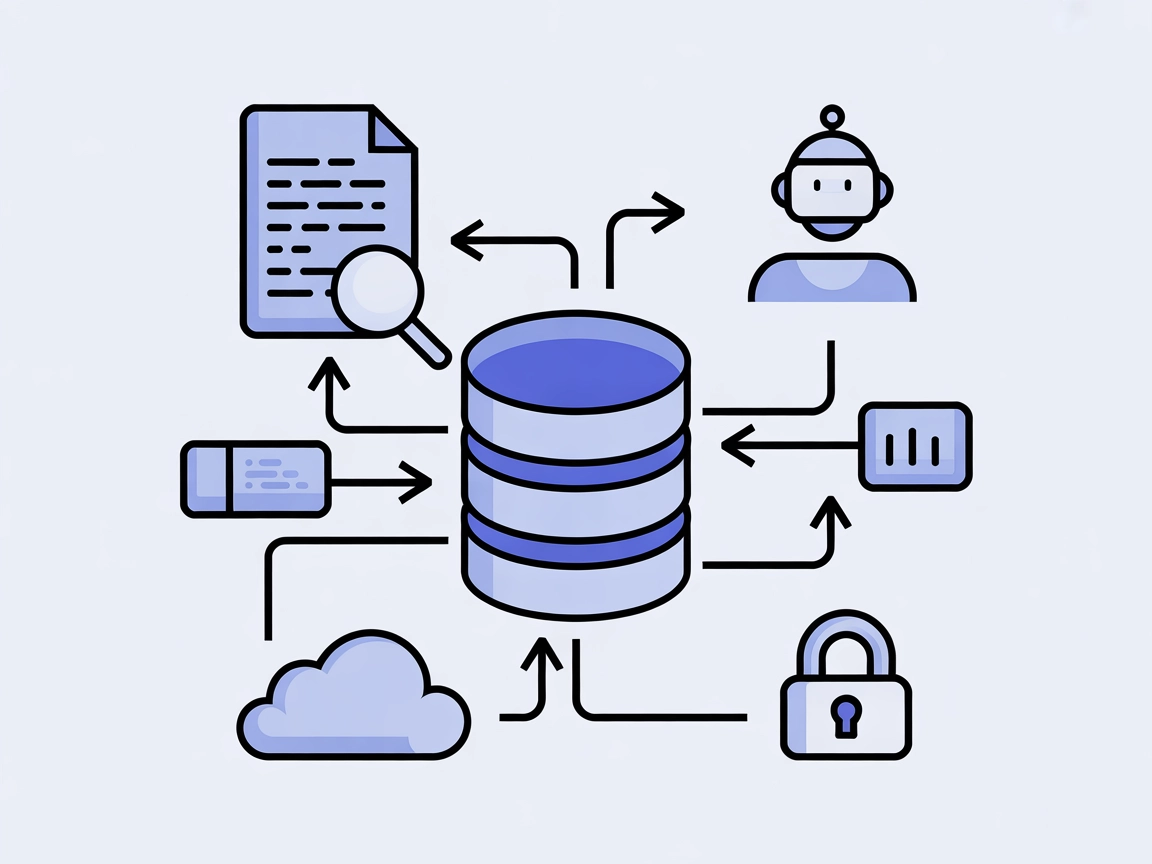

Integre facilmente o Google Vertex AI Search com seus agentes de IA para permitir buscas confiáveis e fundamentadas em conjuntos de dados privados com o Servidor MCP do VertexAI Search.

O que faz o Servidor MCP do “VertexAI Search”?

O Servidor MCP do VertexAI Search foi projetado para conectar assistentes de IA ao Google Vertex AI Search, permitindo que pesquisem e recuperem informações de conjuntos de dados privados armazenados no Vertex AI Datastore. Ao aproveitar o Gemini com o grounding do Vertex AI, este servidor aprimora a qualidade e precisão dos resultados de busca ao fundamentar as respostas da IA em seus dados proprietários. Ele suporta integração com um ou vários armazenamentos de dados do Vertex AI, tornando-se uma ferramenta poderosa para aumentar fluxos de trabalho impulsionados por LLMs com informações contextualmente relevantes e específicas da organização. Essa capacidade permite que desenvolvedores automatizem buscas de documentos, consultas a bases de conhecimento e otimizem o acesso a dados empresariais em ambientes de desenvolvimento e produção.

Lista de Prompts

Nenhum modelo de prompt é mencionado no repositório.

Lista de Recursos

Nenhum recurso específico é detalhado no repositório.

Lista de Ferramentas

Nenhuma lista explícita de ferramentas é fornecida no repositório ou em server.py.

Casos de Uso deste Servidor MCP

- Automação de Busca Empresarial: Integre o Vertex AI Search em fluxos de trabalho para automatizar a consulta e recuperação de documentos em conjuntos de dados privados, facilitando o acesso interno à informação.

- Aumento de Base de Conhecimento: Aprimore assistentes de IA com a capacidade de responder a perguntas dos usuários fundamentadas no conhecimento específico da organização, aumentando a precisão das respostas.

- Tomada de Decisão Orientada por Dados: Permita que desenvolvedores destaquem dados relevantes dos Datastores do Vertex AI durante o desenvolvimento de aplicações, apoiando decisões baseadas em evidências.

- Desenvolvimento de Assistentes de IA Personalizados: Construa agentes de IA específicos de domínio capazes de pesquisar e contextualizar respostas usando armazenamentos de dados do Vertex AI selecionados.

Como configurar

Windsurf

- Certifique-se de que Python e Docker estão instalados em seu sistema.

- Clone o repositório:

git clone git@github.com:ubie-oss/mcp-vertexai-search.git - Crie um ambiente virtual e instale as dependências:

uv venv uv sync --all-extras - Adicione a configuração do servidor MCP no arquivo de configuração do Windsurf conforme abaixo:

{ "mcpServers": { "vertexai-search": { "command": "uv", "args": ["run", "mcp-vertexai-search"] } } } - Salve e reinicie o Windsurf, depois verifique se o servidor MCP está em execução.

Exemplo de Proteção de Chaves de API:

{

"mcpServers": {

"vertexai-search": {

"env": {

"GOOGLE_APPLICATION_CREDENTIALS": "/path/to/your/credentials.json"

},

"inputs": {}

}

}

}

Claude

- Certifique-se de que o ambiente Python apropriado e as dependências estejam instalados.

- Clone e configure o repositório como acima.

- Edite a configuração do Claude para adicionar o servidor MCP:

{ "mcpServers": { "vertexai-search": { "command": "uv", "args": ["run", "mcp-vertexai-search"] } } } - Reinicie o Claude e verifique o status do servidor.

Exemplo de Proteção de Chaves de API:

{

"mcpServers": {

"vertexai-search": {

"env": {

"GOOGLE_APPLICATION_CREDENTIALS": "/path/to/your/credentials.json"

},

"inputs": {}

}

}

}

Cursor

- Instale os pré-requisitos e configure o repositório conforme descrito acima.

- Atualize o arquivo de configuração do Cursor:

{ "mcpServers": { "vertexai-search": { "command": "uv", "args": ["run", "mcp-vertexai-search"] } } } - Salve, reinicie o Cursor e verifique a operação.

Exemplo de Proteção de Chaves de API:

{

"mcpServers": {

"vertexai-search": {

"env": {

"GOOGLE_APPLICATION_CREDENTIALS": "/path/to/your/credentials.json"

},

"inputs": {}

}

}

}

Cline

- Siga os passos para configuração do repositório como acima.

- Modifique a configuração do Cline:

{ "mcpServers": { "vertexai-search": { "command": "uv", "args": ["run", "mcp-vertexai-search"] } } } - Reinicie o Cline e confirme que o servidor está ativo.

Exemplo de Proteção de Chaves de API:

{

"mcpServers": {

"vertexai-search": {

"env": {

"GOOGLE_APPLICATION_CREDENTIALS": "/path/to/your/credentials.json"

},

"inputs": {}

}

}

}

Como usar este MCP em fluxos

Usando MCP no FlowHunt

Para integrar servidores MCP em seu fluxo do FlowHunt, comece adicionando o componente MCP ao seu fluxo e conectando-o ao seu agente de IA:

Clique no componente MCP para abrir o painel de configuração. Na seção de configuração do MCP do sistema, insira os detalhes do seu servidor MCP usando este formato JSON:

{

"vertexai-search": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Depois de configurado, o agente de IA poderá usar este MCP como uma ferramenta com acesso a todas as suas funções e capacidades. Lembre-se de trocar “vertexai-search” pelo nome real do seu servidor MCP e substituir a URL pela URL do seu próprio servidor MCP.

Visão Geral

| Seção | Disponibilidade | Detalhes/Notas |

|---|---|---|

| Visão Geral | ✅ | Presente no README.md |

| Lista de Prompts | ⛔ | Nenhum modelo de prompt encontrado |

| Lista de Recursos | ⛔ | Nenhum recurso explícito detalhado |

| Lista de Ferramentas | ⛔ | Nenhuma ferramenta explícita listada |

| Proteção de Chaves de API | ✅ | Exemplos de configuração fornecidos |

| Suporte a Sampling (menos importante na avaliação) | ⛔ | Não mencionado |

Com base na completude da documentação e exposição de funcionalidades, este servidor MCP oferece uma integração sólida para o Vertex AI Search mas carece de documentação detalhada sobre prompts, recursos e ferramentas. As instruções de configuração e licenciamento são claras, mas funcionalidades avançadas do MCP não são discutidas. Nota: 5/10

Pontuação MCP

| Possui LICENSE | ✅ (Apache-2.0) |

|---|---|

| Possui ao menos uma ferramenta | ⛔ |

| Número de Forks | 9 |

| Número de Stars | 18 |

Perguntas frequentes

- O que é o Servidor MCP do VertexAI Search?

O Servidor MCP do VertexAI Search conecta assistentes de IA ao Google Vertex AI Search, permitindo que pesquisem e recuperem informações de conjuntos de dados privados no Vertex AI Datastore. Ele fundamenta as respostas da IA nos dados da sua organização para maior precisão e contexto.

- Quais são os casos de uso típicos?

Os casos de uso incluem automação da busca de documentos empresariais, aumento de bases de conhecimento, desenvolvimento orientado a dados e construção de assistentes de IA personalizados que utilizam conjuntos de dados proprietários.

- Como proteger minhas credenciais de API?

Defina a variável de ambiente GOOGLE_APPLICATION_CREDENTIALS na sua configuração MCP, apontando para o arquivo JSON de credenciais da conta de serviço do Google Cloud. Exemplos de configuração são fornecidos para cada cliente suportado.

- Posso usar múltiplos Vertex AI Datastores?

Sim, o servidor suporta integração com um ou vários Vertex AI Datastores, permitindo consultar diversos conjuntos de dados privados conforme necessário.

- Onde posso ver o servidor MCP em ação dentro do FlowHunt?

Adicione o componente MCP ao seu fluxo, configure-o com os dados do seu servidor e conecte-o ao seu agente de IA. O agente poderá então acessar todas as funções fornecidas pelo Servidor MCP do VertexAI Search.

Experimente o Servidor MCP do VertexAI Search no FlowHunt

Potencialize seus agentes de IA com busca em conjuntos de dados privados e respostas fundamentadas. Integre o Servidor MCP do VertexAI Search em apenas alguns passos.