Cache Augmented Generation (CAG)

Cache Augmented Generation (CAG) zvyšuje efektivitu veľkých jazykových modelov prednahrávaním statických znalostí, znižuje latenciu a zjednodušuje architektúru pre statické úlohy s nízkou latenciou.

Čo je Cache Augmented Generation (CAG)?

Cache Augmented Generation (CAG) je nový prístup na zvýšenie výkonu a efektivity veľkých jazykových modelov (LLM) využitím prednahraných znalostí vo forme vopred vypočítaných kľúč-hodnota (KV) cache.

Na rozdiel od Retrieval Augmented Generation (RAG), ktorý počas inferencie dynamicky získava externé znalosti, CAG úplne eliminuje kroky získavania tým, že všetky relevantné znalosti vloží priamo do rozšíreného kontextového okna modelu ešte pred inferenciou. Táto stratégia prednahrávania umožňuje LLM generovať odpovede na základe vopred vypočítaných informácií, čo výrazne znižuje latenciu a zjednodušuje architektúru systému.

Uchovávaním spracovaných znalostí v kľúč-hodnota cache CAG zabezpečuje, že model má okamžitý prístup k potrebnému kontextu na zodpovedanie otázok. Tento prístup je obzvlášť výhodný v scenároch, kde je znalostná báza statická, relatívne malá alebo kde je prioritou nízka latencia.

Ako CAG funguje?

CAG pracuje v troch hlavých fázach:

1. Prednahrávanie externých znalostí

Všetky relevantné dokumenty alebo datasety sú prednahrané do kontextového okna modelu pred inferenciou.

Prednahraný obsah je spracovaný do kľúč-hodnota (KV) cache, ktorá zachytáva internú reprezentáciu znalostí modelom. Napríklad:

def preprocess_knowledge(model, tokenizer, prompt): input_ids = tokenizer.encode(prompt, return_tensors="pt").to(model.device) past_key_values = DynamicCache() outputs = model(input_ids=input_ids, past_key_values=past_key_values, use_cache=True) return outputs.past_key_values

Tento krok zabezpečuje, že model má okamžitý prístup k predspracovaným znalostiam, čím obchádza potrebu získavania v reálnom čase.

2. Inferencia s vopred vypočítanou cache

Keď je položená otázka, vopred vypočítaná KV cache je skombinovaná so vstupom dotazu.

Model generuje odpoveď výlučne na základe cache a dotazu, bez ďalších výpočtov na získavanie znalostí. Napríklad:

def generate_response(model, query, kv_cache): input_ids = tokenizer.encode(query, return_tensors="pt").to(model.device) output_ids = model(input_ids=input_ids, past_key_values=kv_cache, use_cache=True) return tokenizer.decode(output_ids)

3. Správa cache

Ako sa spracúvajú nové dotazy, cache rastie. Mechanizmus resetovania oreže cache späť na pôvodnú dĺžku, aby sa zachoval výkon a zabezpečilo, že ďalšie dotazy budú posudzované v zamýšľanom kontexte. Príklad resetovania cache:

def clean_up(kv_cache, original_length): for i in range(len(kv_cache.key_cache)): kv_cache.key_cache[i] = kv_cache.key_cache[i][:, :, :original_length, :] kv_cache.value_cache[i] = kv_cache.value_cache[i][:, :, :original_length, :]

Kľúčové výhody CAG

Nízka latencia

Keďže nie je potrebné získavanie v reálnom čase, CAG ponúka rýchlejšie odpovede v porovnaní s RAG. Je teda ideálny pre časovo citlivé aplikácie.Vyššia presnosť

Prednahraním všetkých relevantných dokumentov CAG zaručuje, že model spracováva komplexný dataset, čím sa znižuje riziko chýb v kontexte alebo chýb pri získavaní.Zjednodušená architektúra

Na rozdiel od RAG, ktorý vyžaduje zložitý retrieval pipeline, CAG má jednoduchú architektúru, čím sa znižuje komplexnosť systému a náklady na údržbu.Efektivita v rozsahu

Po prednahraní a uložení znalostí sú nasledujúce dotazy spracované s minimálnou výpočtovou záťažou, vďaka čomu je CAG efektívny pri opakovaných otázkach v rámci jednej znalostnej domény.

Obmedzenia CAG

Veľkosť kontextového okna

CAG sa spolieha na kontextové okno modelu na prednahratie znalostí. Súčasné LLM podporujú kontextové okná do 128 000 tokenov, čo obmedzuje množstvo znalostí, ktoré je možné nahrať.Veľkosť znalostnej bázy

CAG je najvhodnejší pre statické a zvládnuteľné znalostné bázy. Pri veľkých alebo dynamických datasetoch môže mať model problém zmestiť všetky relevantné informácie do kontextového okna.Statické znalosti

CAG predpokladá, že znalostná báza sa počas inferencie nemení. Je menej efektívny pre prípady, ktoré vyžadujú aktualizácie v reálnom čase alebo dynamickú integráciu znalostí.Nákladové dôsledky

Veľké kontextové okná zvyšujú výpočtové náklady počas prednahrávania, vďaka čomu je CAG menej ekonomický pre scenáre s častými aktualizáciami alebo zmenami v znalostnej báze.

Ako sa CAG používa?

Praktické aplikácie

CAG sa najčastejšie využíva v prípadoch, kde je znalostná báza statická, zvládnuteľnej veľkosti a nízka latencia je kritická:

Chatboty zákazníckej podpory

Príklad: Prednahranie bežných krokov riešenia problémov so softvérovými produktmi pre okamžité odpovede používateľom.

Výhoda: Eliminuje chyby pri získavaní a zrýchľuje odpovede.Analýza dokumentov

Príklad: Finančné inštitúcie analyzujú kvartálne správy alebo právnické firmy vyhľadávajú v regulačných dokumentoch.

Výhoda: Zabezpečuje konzistentné a presné odpovede prednahraním všetkých relevantných dokumentov do modelu.Zdravotnícki asistenti

Príklad: Prednahranie zdravotníckych odporúčaní na asistenciu pacientskym dotazom.

Výhoda: Udržiava kontinuitu v multi-turn dialógoch a zabezpečuje presné odkazy.Vzdelávanie a školenia

Príklad: Odpovedanie na často kladené otázky vo firemných školiacich programoch.

Výhoda: Zjednodušuje nasadenie a zaručuje konzistentné odpovede.

Porovnanie s Retrieval Augmented Generation (RAG)

| Funkcia | CAG | RAG |

|---|---|---|

| Práca so znalosťami | Prednahráva znalosti do kontextového okna. | Dynamicky získava znalosti pri behu. |

| Systémová komplexnosť | Zjednodušený, nevyžaduje retrieval pipeline. | Vyžaduje ďalšie komponenty na získavanie. |

| Latencia | Nízka, keďže kroky získavania sú eliminované. | Vyššia kvôli získavaniu v reálnom čase. |

| Škálovateľnosť | Limitovaná veľkosťou kontextového okna. | Dobre škáluje s veľkými, dynamickými datasetmi. |

| Riziko chýb | Žiadne chyby pri získavaní. | Náchylný na chyby pri získavaní a hodnotení. |

| Najlepšie použitie | Statické úlohy s nízkou latenciou. | Dynamické, veľké alebo často aktualizované úlohy. |

Príklady použitia

CAG v praxi

HR systémy

Spoločnosť používa CAG na prednahratie zamestnaneckých smerníc do modelu. Zamestnanci sa môžu pýtať na konkrétne pravidlá a odpovede sú generované okamžite.Právna asistencia

Právny asistent prednahrá relevantné zákony do kontextu modelu a poskytuje rýchle odpovede na právne otázky bez použitia retrieval systému.Zákaznícka podpora

Chatbot SaaS produktu využíva CAG na prednahratie FAQ a návodov na riešenie problémov, čím zabezpečuje plynulé a rýchle interakcie so zákazníkmi.

RAG pre dynamické scenáre

Agregácia správ

Spravodajská aplikácia používa RAG na vyhľadávanie a sumarizáciu najnovších článkov, dynamicky získava najrelevantnejšie informácie pre dotazy používateľov.Vyhľadávanie v e-shope

RAG sa používa na získavanie detailov o produktoch a dostupnosti z veľkého a často aktualizovaného katalógu.Výskumné platformy

Vedecká platforma využíva RAG na získavanie relevantných článkov a štúdií z veľkých externých databáz.

Príklad implementácie: Prednahratie znalostí v Pythone

Nasledujúci kód v Pythone demonštruje, ako prednahrávať znalosti do modelu pre CAG:

def preprocess_knowledge(model, tokenizer, prompt):

input_ids = tokenizer.encode(prompt, return_tensors="pt").to(model.device)

past_key_values = DynamicCache()

outputs = model(input_ids=input_ids, past_key_values=past_key_values, use_cache=True)

return outputs.past_key_values

Tento mechanizmus prednahrávania zabezpečuje, že model spracováva dotazy bez potreby externého získavania, čo umožňuje efektívny a nízkolatenčný výkon.

Kedy použiť CAG

Statické znalostné bázy

Ideálne, ak sa znalostná báza nemení často.Aplikácie s nízkou latenciou

Vhodné pre zákaznícku podporu, vzdelávanie alebo zdravotnícke systémy, kde sú potrebné rýchle odpovede.Nákladovo efektívne scenáre

Výhodné, keď prednahrané znalosti ostávajú konzistentné naprieč viacerými dotazmi, čím sa znižuje výpočtová záťaž.

CAG je efektívna alternatíva k RAG pre úlohy vyžadujúce rýchlosť, jednoduchosť a konzistenciu. Je však obmedzený veľkosťou a statickým charakterom znalostnej bázy.

Výskum o Cache Augmented Generation (CAG)

1. Adaptive Contextual Caching for Mobile Edge Large Language Model Service

Autori: Guangyuan Liu, Yinqiu Liu, Jiacheng Wang, Hongyang Du, Dusit Niyato, Jiawen Kang, Zehui Xiong

Tento článok sa zameriava na výzvy v nasadzovaní veľkých jazykových modelov (LLM) na mobilnom edge, ako sú obmedzené výpočtové zdroje a vysoká latencia pri získavaní. Navrhuje rámec Adaptive Contextual Caching (ACC), ktorý využíva hlboké posilňovacie učenie (DRL) na optimalizáciu politiky výmeny cache zohľadňovaním používateľského kontextu, podobnosti dokumentov a nákladov na cache miss. Experimentálne výsledky ukazujú, že ACC dosahuje viac ako 80% hit rate cache po 11 epizódach trénovania, pričom významne znižuje latenciu pri získavaní až o 40% v porovnaní s tradičnými metódami. Navyše minimalizuje lokálne náklady na cache až o 55%, čím je vhodný pre škálovateľné, nízkolatenčné LLM služby v prostredí s obmedzenými zdrojmi. Práca poukazuje na potenciál ACC zvýšiť efektivitu edge LLM systémov.

Prečítajte si článok tu

2. Towards More Economical Context-Augmented LLM Generation by Reusing Stored KV Cache

Autori: Hanchen Li, Yuhan Liu, Yihua Cheng, Kuntai Du, Junchen Jiang

Táto štúdia skúma opätovné použitie kľúč-hodnota (KV) cache na zníženie oneskorení pri predvyplňovaní v LLM aplikáciách, najmä pri opakovaných vstupných textoch. Skúma, či je takéto opätovné použitie cache ekonomicky výhodné aj pri využívaní verejných cloudových služieb na ukladanie a spracovanie. Autori navrhujú analytický model na hodnotenie cloudových nákladov (výpočty, úložisko, sieť) na ukladanie a opätovné využívanie KV cache pri rôznych parametroch pracovnej záťaže. Štúdia preukazuje, že opätovné použitie KV cache šetrí čas aj cloudové náklady pri dlhších kontextoch, čím podnecuje ďalší vývoj ekonomických context-augmented LLM systémov.

Prečítajte si článok tu

3. MPIC: Position-Independent Multimodal Context Caching System for Efficient MLLM Serving

Autori: Shiju Zhao, Junhao Hu, Rongxiao Huang, Jiaqi Zheng, Guihai Chen

Tento článok predstavuje MPIC, polohovo nezávislý systém multimodálneho kontextového cacheovania, zameraný na riešenie neefektívnosti v multimodálnych veľkých jazykových modeloch (MLLM). Tradičné systémy opätovne prepočítavajú celú KV cache aj pri malých zmenách v kontexte, čo vedie k neefektívnosti. MPIC ponúka polohovo nezávislý systém cache, ktorý ukladá KV cache lokálne alebo vzdialene a paralelizuje výpočty a načítavanie cache počas inferencie. Integrované mechanizmy opätovného využitia a prepočtu zmierňujú degradáciu presnosti a zároveň dosahujú až 54% zníženie času odozvy v porovnaní s existujúcimi metódami. Práca zdôrazňuje potenciál na zvýšenie efektivity pri nasadzovaní multimodálnych LLM systémov.

Prečítajte si článok tu

Najčastejšie kladené otázky

- Čo je Cache Augmented Generation (CAG)?

Cache Augmented Generation (CAG) je metóda, ktorá zlepšuje výkon veľkých jazykových modelov (LLM) prednahrávaním statických znalostí do vopred vypočítanej kľúč-hodnota (KV) cache. Na rozdiel od Retrieval Augmented Generation (RAG), ktorý získava externé znalosti v reálnom čase, CAG vkladá všetky relevantné informácie vopred, čím znižuje latenciu a zjednodušuje architektúru AI systému.

- Ako sa CAG líši od RAG?

CAG prednahráva všetky potrebné znalosti do kontextového okna modelu pred inferenciou a eliminuje potrebu získavania v reálnom čase, čo zaručuje nízku latenciu. RAG naopak dynamicky získava relevantné informácie počas behu, čo môže viesť k chybám pri získavaní a vyššej latencii, no je vhodnejší pre dynamické alebo často aktualizované znalostné bázy.

- Aké sú výhody používania CAG?

Kľúčové výhody CAG zahŕňajú nízku latenciu, vyššiu presnosť vďaka komplexnému prednahrávaniu, zjednodušenú systémovú architektúru a efektivitu pri opakovaných otázkach v rámci statických znalostných domén.

- Aké sú obmedzenia CAG?

CAG je limitovaný maximálnou veľkosťou kontextového okna modelu (aktuálne do 128 000 tokenov), je najvhodnejší pre statické a zvládnuteľné znalostné bázy a je menej efektívny pri dynamických dátach alebo v scenároch vyžadujúcich časté aktualizácie. Veľké kontextové okná môžu tiež zvýšiť výpočtové náklady počas prednahrávania.

- Kde je CAG najviac užitočný?

CAG je ideálny pre statické aplikácie s nízkou latenciou, ako sú chatboty zákazníckej podpory, analýza dokumentov, zdravotnícki asistenti, vzdelávacie FAQ, otázky k HR politikám a právni asistenti—všade tam, kde sa znalostná báza mení zriedka a sú potrebné okamžité odpovede.

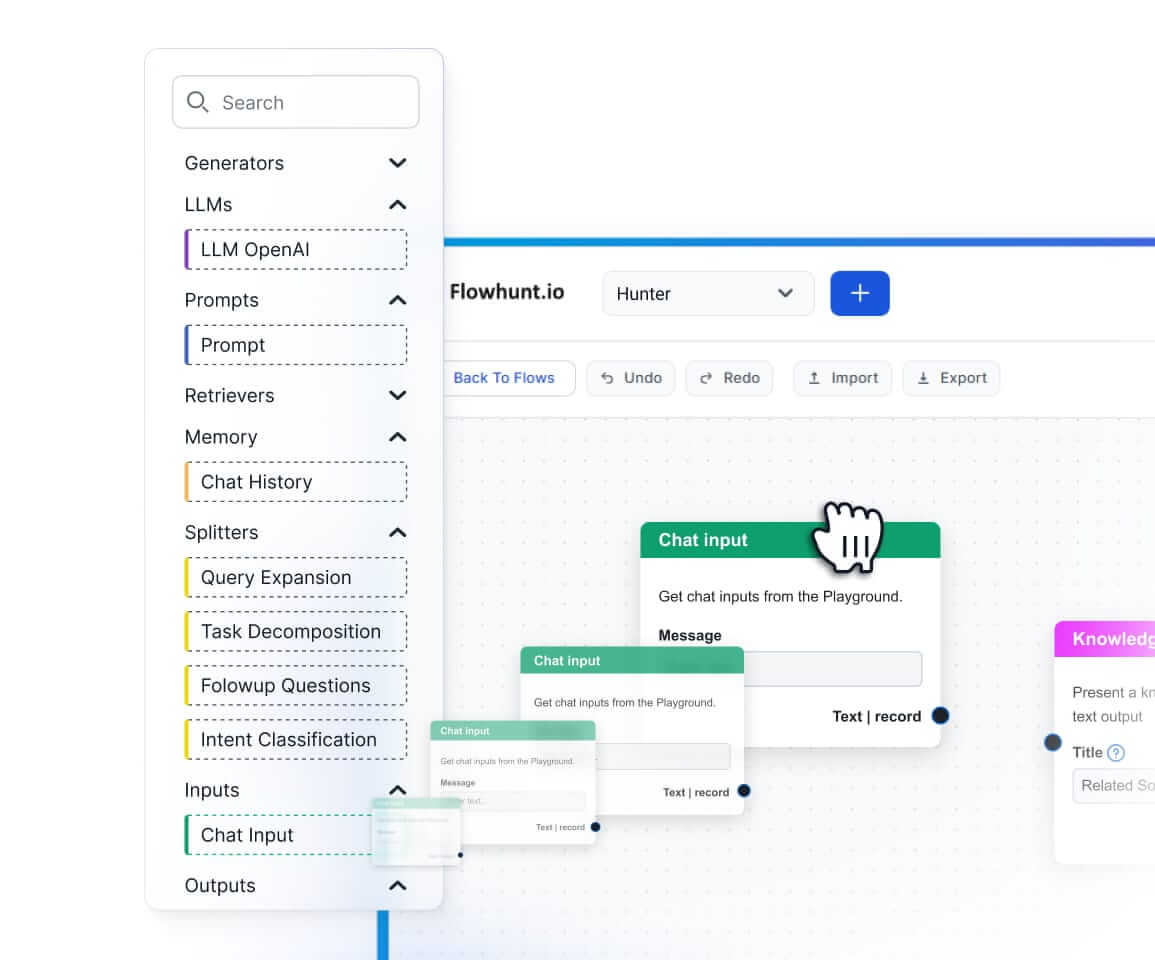

Začnite budovať efektívne AI workflowy

Zažite silu CAG a ďalších AI nástrojov s FlowHunt. Naplánujte si demo a zistite, ako riešenia s nízkou latenciou a cache-augmentáciou môžu transformovať vaše podnikanie.