Interpretovateľnosť modelu

Interpretovateľnosť modelu je schopnosť porozumieť a dôverovať predikciám AI, čo je nevyhnutné pre transparentnosť, súlad a zmiernenie zaujatosti v oblastiach ako zdravotníctvo a financie.

Interpretovateľnosť modelu

Interpretovateľnosť modelu znamená porozumieť a dôverovať predikciám AI, čo je kľúčové v oblastiach ako zdravotníctvo a financie. Zahŕňa globálnu a lokálnu interpretovateľnosť, podporuje dôveru, súlad a zmierňovanie zaujatosti prostredníctvom vnútorných a post-hoc metód.

Interpretovateľnosť modelu znamená schopnosť porozumieť, vysvetliť a dôverovať predikciám a rozhodnutiam, ktoré robia modely strojového učenia. Je to kľúčová súčasť sveta umelej inteligencie, najmä v aplikáciách, ktoré zahŕňajú rozhodovanie, ako je zdravotníctvo, financie a autonómne systémy. Tento pojem je ústredný v dátovej vede, pretože preklenuje priepasť medzi zložitými výpočtovými modelmi a ľudským porozumením.

Čo je interpretovateľnosť modelu?

Interpretovateľnosť modelu je miera, do akej človek dokáže konzistentne predpovedať výsledky modelu a pochopiť príčinu predikcie. Zahŕňa porozumenie vzťahu medzi vstupnými znakmi a výsledkami produkovanými modelom, čo umožňuje zainteresovaným stranám pochopiť dôvody konkrétnych predikcií. Toto porozumenie je kľúčové pri budovaní dôvery, zabezpečení súladu s reguláciami a pri riadení rozhodovacích procesov.

Podľa rámca, ktorý diskutovali Lipton (2016) a Doshi-Velez & Kim (2017), interpretovateľnosť zahŕňa schopnosť hodnotiť a získavať informácie z modelov, ktoré samotný cieľ nevie sprostredkovať.

Globálna vs. lokálna interpretovateľnosť

Interpretovateľnosť modelu možno rozdeliť na dva hlavné typy:

Globálna interpretovateľnosť: Poskytuje celkový prehľad o tom, ako model pracuje, čím dáva pohľad na jeho všeobecný rozhodovací proces. Zahŕňa porozumenie štruktúre modelu, jeho parametrom a vzťahom, ktoré zachytáva z dátovej množiny. Tento typ interpretovateľnosti je dôležitý na hodnotenie správania modelu v širokom spektre vstupov.

Lokálna interpretovateľnosť: Zameriava sa na vysvetlenie jednotlivých predikcií, poskytuje pohľad na to, prečo model urobil konkrétne rozhodnutie pre konkrétny prípad. Lokálna interpretovateľnosť pomáha pochopiť správanie modelu v špecifických situáciách a je dôležitá pri ladení a zdokonaľovaní modelov. Metódy ako LIME a SHAP sa často používajú na dosiahnutie lokálnej interpretovateľnosti približovaním rozhodovacej hranice modelu okolo konkrétneho prípadu.

Dôležitosť interpretovateľnosti modelu

Dôvera a transparentnosť

Interpretovateľné modely majú väčšiu šancu získať dôveru používateľov a zainteresovaných strán. Transparentnosť v tom, ako model dospieva k svojim rozhodnutiam, je kľúčová, najmä v oblastiach ako zdravotníctvo alebo financie, kde môžu mať rozhodnutia významné etické a právne dôsledky. Interpretovateľnosť uľahčuje porozumenie a ladenie, čím zaisťuje, že modelom možno dôverovať a spoliehať sa na ne v kritických rozhodovacích procesoch.

Bezpečnosť a súlad s reguláciami

V oblastiach s vysokými stávkami, ako je medicínska diagnostika alebo autonómne riadenie, je interpretovateľnosť nevyhnutná na zaistenie bezpečnosti a splnenie regulačných štandardov. Napríklad Všeobecné nariadenie o ochrane údajov (GDPR) v Európskej únii vyžaduje, aby mali jednotlivci právo na vysvetlenie algoritmických rozhodnutí, ktoré ich významne ovplyvňujú. Interpretovateľnosť modelu pomáha inštitúciám dodržiavať tieto regulácie tým, že poskytuje jasné vysvetlenia algoritmických výstupov.

Odhaľovanie a zmierňovanie zaujatosti

Interpretovateľnosť je zásadná pre identifikáciu a zmierňovanie zaujatia v modeloch strojového učenia. Modely trénované na zaujatých dátach môžu neúmyselne preberať a šíriť spoločenské predsudky. Porozumením rozhodovaciemu procesu môžu odborníci identifikovať zaujaté znaky a upraviť modely tak, aby podporovali spravodlivosť a rovnosť v AI systémoch.

Ladenie a zlepšovanie modelu

Interpretovateľné modely uľahčujú proces ladenia, keďže dátoví vedci môžu porozumieť a opraviť chyby v predikciách. Toto porozumenie vedie k zlepšeniam a vylepšeniam modelu, čím sa zabezpečuje lepší výkon a presnosť. Interpretovateľnosť pomáha odhaliť základné príčiny chýb alebo neočakávaného správania modelu a tým usmerňuje ďalší vývoj modelu.

Metódy dosahovania interpretovateľnosti

Na zvýšenie interpretovateľnosti modelu možno použiť viacero techník a prístupov, ktoré spadajú do dvoch hlavných kategórií: vnútorné a post-hoc metódy.

Vnútorná interpretovateľnosť

Zahŕňa použitie modelov, ktoré sú vďaka svojej jednoduchosti a transparentnosti prirodzene interpretovateľné. Medzi príklady patria:

- Lineárna regresia: Poskytuje priamočiare pohľady na to, ako vstupné znaky ovplyvňujú predikcie, čo uľahčuje ich pochopenie a analýzu.

- Rozhodovacie stromy: Ponúkajú vizuálne a logické znázornenie rozhodnutí, vďaka čomu sú ľahko interpretovateľné a komunikovateľné so zainteresovanými stranami.

- Pravidlové modely: Používajú súbor pravidiel na rozhodovanie, ktoré možno priamo analyzovať a pochopiť, čím poskytujú jasné pohľady na rozhodovací proces.

Post-hoc interpretovateľnosť

Tieto metódy sa používajú na zložité modely po trénovaní, aby boli interpretovateľnejšie:

- LIME (Local Interpretable Model-agnostic Explanations): Poskytuje lokálne vysvetlenia približovaním predikcií modelu interpretovateľnými modelmi v okolí zvoleného prípadu, čo pomáha pochopiť špecifické predikcie.

- SHAP (SHapley Additive exPlanations): Ponúka jednotné meranie dôležitosti znakov zohľadnením príspevku každého znaku k predikcii, čím poskytuje pohľad na rozhodovací proces modelu.

- Čiastočné závislostné grafy (PDPs): Vizualizujú vzťah medzi znakom a predikovaným výsledkom, pričom marginalizujú ostatné znaky, čo umožňuje pochopiť vplyv znaku.

- Mapy saliencie: Zvýrazňujú oblasti v vstupných dátach, ktoré najviac ovplyvňujú predikcie, často sa používajú pri spracovaní obrazov na pochopenie zamerania modelu.

Príklady použitia interpretovateľnosti modelu

Zdravotníctvo

Pri medicínskej diagnostike je interpretovateľnosť nevyhnutná na overenie predikcií AI a zabezpečenie toho, že sú v súlade s klinickými poznatkami. Modely používané pri diagnostike chorôb alebo odporúčaní liečebných plánov musia byť interpretovateľné, aby si získali dôveru zdravotníckych pracovníkov a pacientov a podporili lepšie zdravotnícke výsledky.

Financie

Finančné inštitúcie využívajú strojové učenie na hodnotenie úverovej bonity, detekciu podvodov a hodnotenie rizika. Interpretovateľnosť zabezpečuje súlad s reguláciami a pomáha porozumieť finančným rozhodnutiam, čo uľahčuje ich obhajobu pred zainteresovanými stranami a regulátormi. To je kľúčové pre udržanie dôvery a transparentnosti vo finančných operáciách.

Autonómne systémy

V autonómnych vozidlách a robotike je interpretovateľnosť dôležitá pre bezpečnosť a spoľahlivosť. Porozumenie rozhodovaciemu procesu AI systémov pomáha predvídať ich správanie v reálnych situáciách a zabezpečuje, že fungujú v rámci etických a právnych hraníc, čo je nevyhnutné pre verejnú bezpečnosť a dôveru.

AI automatizácia a chatboty

Pri AI automatizácii a chatbotoch interpretovateľnosť pomáha pri vylepšovaní konverzačných modelov a zabezpečení, že poskytujú relevantné a presné odpovede. Umožňuje porozumieť logike interakcií chatbotov a zlepšovať spokojnosť používateľov, čím sa zvyšuje celkový používateľský zážitok.

Výzvy a obmedzenia

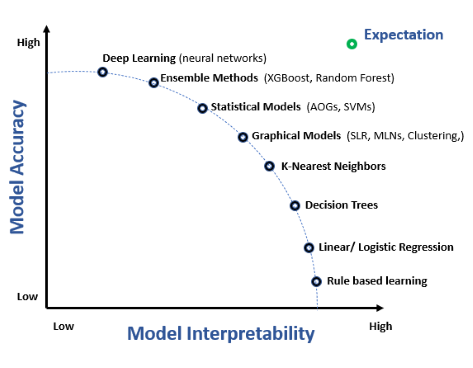

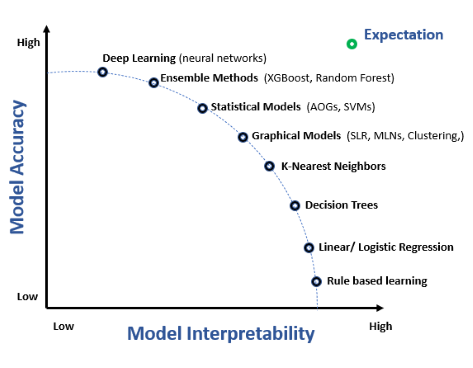

Kompromis medzi interpretovateľnosťou a presnosťou

Často existuje kompromis medzi interpretovateľnosťou modelu a jeho presnosťou. Zložité modely, ako hlboké neurónové siete, môžu ponúkať vyššiu presnosť, ale sú menej interpretovateľné. Dosiahnuť rovnováhu medzi týmito dvoma aspektmi je významná výzva pri vývoji modelov a vyžaduje si dôkladné zváženie potrieb aplikácie a požiadaviek zainteresovaných strán.

Špecifická interpretovateľnosť podľa domény

Úroveň požadovanej interpretovateľnosti sa môže výrazne líšiť v závislosti od domény a aplikácie. Modely musia byť prispôsobené špecifickým potrebám a požiadavkám daného odvetvia tak, aby poskytovali zmysluplné a použiteľné poznatky. To zahŕňa pochopenie výziev konkrétnej oblasti a navrhovanie modelov, ktoré ich efektívne riešia.

Hodnotenie interpretovateľnosti

Meranie interpretovateľnosti je náročné, pretože je subjektívne a závislé od kontextu. Zatiaľ čo niektoré modely môžu byť interpretovateľné pre odborníkov, laikom nemusia byť zrozumiteľné. Vývoj štandardizovaných metrík na hodnotenie interpretovateľnosti je stále predmetom výskumu a je kľúčový pre ďalší rozvoj tohto odboru a nasadzovanie interpretovateľných modelov.

Výskum interpretovateľnosti modelu

Interpretovateľnosť modelu je kľúčovým zameraním v strojovom učení, pretože umožňuje porozumenie a dôveru v prediktívne modely, najmä v oblastiach ako precízna medicína a automatizované rozhodovacie systémy. Tu je niekoľko významných štúdií, ktoré sa tejto problematike venujú:

Hybridný prediktívny model: Keď interpretovateľný model spolupracuje s black-box modelom

Autori: Tong Wang, Qihang Lin (Publikované: 2019-05-10)

Táto štúdia predstavuje rámec na vytváranie hybridného prediktívneho modelu (HPM), ktorý spája výhody interpretovateľných a black-box modelov. Hybridný model nahrádza black-box model v častiach dát, kde nie je potrebný vysoký výkon, čím zvyšuje transparentnosť s minimálnou stratou presnosti. Autori navrhujú cieľovú funkciu, ktorá zohľadňuje prediktívnu presnosť, interpretovateľnosť a transparentnosť modelu. Štúdia demonštruje účinnosť hybridného modelu pri vyvažovaní transparentnosti a prediktívneho výkonu, najmä pri štruktúrovaných a textových dátach. Prečítať viacInterpretovateľnosť modelov strojového učenia pre precíznu medicínu

Autori: Gajendra Jung Katuwal, Robert Chen (Publikované: 2016-10-28)

Tento výskum zdôrazňuje dôležitosť interpretovateľnosti modelov strojového učenia v precíznej medicíne. Používa algoritmus Model-Agnostic Explanations na interpretáciu zložitých modelov, ako sú náhodné lesy. Štúdia aplikovala tento prístup na MIMIC-II dataset, kde predikovala úmrtnosť na JIS s 80 % vyváženou presnosťou a objasnila vplyv jednotlivých znakov, čo je kľúčové pre medicínske rozhodovanie. Prečítať viacDefinície interpretovateľnosti a učenie interpretovateľných modelov

Autori: Weishen Pan, Changshui Zhang (Publikované: 2021-05-29)

Štúdia navrhuje novú matematickú definíciu interpretovateľnosti modelov strojového učenia. Definuje interpretovateľnosť z pohľadu ľudských poznávacích systémov a uvádza rámec na trénovanie plne ľudsky interpretovateľných modelov. Výskum ukázal, že takéto modely poskytujú nielen transparentné rozhodovacie procesy, ale sú aj odolnejšie voči adversariálnym útokom. Prečítať viac

Najčastejšie kladené otázky

- Čo je interpretovateľnosť modelu v strojovom učení?

Interpretovateľnosť modelu je miera, do akej dokáže človek konzistentne predvídať a pochopiť výsledky modelu, vysvetliť, ako vstupné znaky súvisia s výsledkami a prečo model robí konkrétne rozhodnutia.

- Prečo je interpretovateľnosť modelu dôležitá?

Interpretovateľnosť buduje dôveru, zabezpečuje súlad s reguláciami, pomáha odhaľovať zaujatosť a uľahčuje ladenie a zlepšovanie AI modelov, najmä v citlivých oblastiach ako zdravotníctvo a financie.

- Čo sú vnútorné a post-hoc metódy interpretovateľnosti?

Vnútorné metódy používajú jednoduché, transparentné modely ako lineárnu regresiu alebo rozhodovacie stromy, ktoré sú interpretovateľné svojou konštrukciou. Post-hoc metódy, ako LIME a SHAP, pomáhajú vysvetliť zložité modely po trénovaní tým, že približujú alebo zvýrazňujú dôležité znaky.

- Aké sú výzvy pri dosahovaní interpretovateľnosti modelu?

Výzvy zahŕňajú vyváženie presnosti s transparentnosťou, špecifické požiadavky domény a subjektívnosť merania interpretovateľnosti, ako aj vývoj štandardizovaných metrík hodnotenia.

Pripravení vytvoriť si vlastnú AI?

Inteligentné chatboty a AI nástroje pod jednou strechou. Prepojte intuitívne bloky a premeňte svoje nápady na automatizované Flows.